| CATEGORII DOCUMENTE |

| Bulgara | Ceha slovaca | Croata | Engleza | Estona | Finlandeza | Franceza |

| Germana | Italiana | Letona | Lituaniana | Maghiara | Olandeza | Poloneza |

| Sarba | Slovena | Spaniola | Suedeza | Turca | Ucraineana |

DOCUMENTE SIMILARE |

|

Budowa i działanie3

a) Głowice5

b) Kodowanie.6

c) MZR..6

d) PRML6

e) Zapis magnetyczny7

Wydajność8

Parametry..9

a) Pojemność..9

b) Czas dostępu.9

c) Liczba talerzy.10

d) Liczba głowic.10

e) Transfer wewnętrzny.10

f) Średni czas dostępu.11

g) Transfer zewnętrzny..11

h) Liczba obrotów na min.11

i) Cache.11

j) MTBF11

k) MBR12

l) Pobór mocy.12

m) Interfejs ATA, macierz, IDE, SCSI13

n) Szybkość obrotowa19

o) Szybkość przesyłania danych19

FAT, HPFS, NTFS20

a) FAT.20

b) HPFS (High Performance File System) system plików OS/2..21

c) NTFS (NT File System) Windows NT.22

d) Oznaczenia producentów.23

Opis naszej pracy dyplomowej pomoże ci szybko zapoznać się z podstawowymi parametrami dysku twardego oraz umożliwi w bardzo prosty sposób poprawnie skonfigurować i partycjonować twardziela.

Każda procedura została opisana zatem wykonanie zadania nie powinno sprawić kłopotów.

W opisie ćwiczenia znajduje się słowniczek, który w łatwy i prosty sposób zaznajomi ciebie z podstawowymi określeniami dotyczącymi dysku twardego.

Dyski twarde.

Dyski twarde są niezbędnym elementem wyposażenia każdego PC, przy czym jest to element istotnie wpływający nie tylko na całkowitą wydajność komputera, ale i na komfort jego używania. Zwłaszcza w kontekście coraz to bardziej rozepchanych pakietów oprogramowania.

Poszczególne krążki dysku twardego pokryte są warstwą ferromagnetyku (dwu-lub trójtlenek żelaza) służącą do zapisu informacji. Krążki te (talerze) pozostają w zwykłych dyskach na stałe w obudowie i tworzą razem z głowicami zapisująco-odczytującymi praktycznie jedną całość.

Trudno dzisiaj sobie wyobrazić peceta bez twardego dysku, który nigdy nie jest za duży.

Nowe programy wymagają coraz szybszych procesorów i modułów pamięci (RAM. Cache). Twardym dyskom poświęca się jakby nieco mniej uwagi, choć mają one nieraz zasadniczy wpływ na ogólną wydajność systemu. Często w praktyce okazuje się, że w seryjnie zmontowanym PC właśnie twardy dysk jest wąskim gardłem, hamując nieraz znacznie cały system.

Twarde dyski z biegiem lat staja się coraz mniejsze, jeśli chodzi o rozmiary i coraz większe, jeśli chodzi o pojemność.

Rozwój technologiczny dysków twardych na przestrzeni ostatnich kilkudziesięciu lat, pod względem dynamiki można porównać chyba tylko z rozwojem układów scalonych. Za pierwszy dysk twardy uznaje się wytworzone przez koncern IBM urządzeni IBM 305 RAMAC (Randmo Access Method of Accounting and Control). Dysk ten ujrzał światło dzienne 13 września 1956 roku i mógł pomieścić zawrotną w tamtych czasach ilość danych: ok. 5MB na, bagatela, 50 talerzach o 20-calowej średnicy każdy!

Pierwszym dyskiem zastosowanym w komputerze PC, a dokładniej w firmowanych przez IBM komputerach IBM PC/XT, był opracowany przez firmę Seagate 5,25-calowy model ST-412. przy znacznie mniejszych od swojego przodka rozmiarach miał aż 10 MB pojemności. Ten pierwszy stosowany w PC dysk już znacznie bardziej przypominał obecnie produkowane modele. Głowice odczytujące i zapisujące dane na talerzach dysku nie dotykały bezpośrednio powierzchni nośnika, czyli podobnie jak w obecnie produkowanych modelach. Oczywiście na początku lat 80. nikt nie słyszał o tak obecnie popularnym w PC interfejsie ATA, a wszystkie parametry wydajnościowe dysku znacznie odbiegały od tego, co udaje się uzyskać, stosując obecnie produkowane modele. Jednak sama idea działania i założenia konstrukcyjne pozostały.

Na początku 1980 roku wprowadzono, wraz z rozpowszechnieniem komputerów osobistych, dostępne dla wszystkich dyski o średnicy 5,25 cala. Ich pojemność wynosiła od 5 do 10 MB.

Dziś napędy HDD wyposażone są w talerze o średnicy 3,5 cala. Ich pojemność liczona jest w gigabajtach.

Budowa i działanie:

Twarde dyski różnią się wymiarami zewnętrznymi, sposobem podłączenia (interfejsem) oraz różnymi procedurami zapisu magnetycznego. Wyróżnić możemy (na podstawie interfejsu) cztery główne typy twardych dysków:

Dyski ze złączem ST506/ST412

Dyski ze złączem ESDI

Dyski ze złączem SCSI

Dyski ze złączem (E)IDE

Standardowym dyskiem w dzisiejszych pecetach jest typ (E)IDE (Enhanced Integrated Device Electronic) oraz, w wydajniejszych systemach, dysk SCSI, który doczekał się w międzyczasie kilku różnych specyfikacji. Różnice w szybkości i przepustowości obu rodzajów dysków są w obecnie produkowanych modelach praktycznie niezauważalne, a przewaga SCSI polega raczej na zaletach samego interfejsu, który pozwala na jednoczesne podłączenie do 7 różnych urządzeń (w wersji standardowej). Związane z tym możliwości konfiguracyjne są zdecydowanie większe niż w przypadku EIDE.

Pozostałe rodzaje twardych dysków to modele już nie produkowane i w zasadzie przestarzałe. Jednakże, ponieważ jeszcze do niedawna były masowo montowane w pecetach i do dziś z powodzeniem wypełniają swoje zadania, zajmiemy się nimi. O tym, czy dany komputer można wyposażyć w nowy lub w dodatkowy twardy dysk decyduje przede wszystkim typ interfejsu.

Stosowana w dyskach sztywnych technika zapisu nie odbiega od tej, z jaką mamy do czynienia w magnetofonie czy w kartach telefonicznych, a także w dyskietkach. Wytwarzane przez elektromagnetyczną głowicę pole magnetyczne powoduje uporządkowanie domen magnetycznych w nośniku ferromagnetycznym o szerokiej pętli histerezy, a ruch tak zapisanego nośnika w pobliżu głowicy odczytującej powoduje w niej indukcję sygnału elektrycznego, odpowiadającego zapisanym danym. Współczesna technologia do odczytu danych używa, zamiast głowic indukcyjnych, półprzewodnikowych elementów magnetorezystywnych, umożliwiających zwiększenie zarówno odczytywalnej gęstości zapisu, jak i zwiększenie szybkości odczytu.

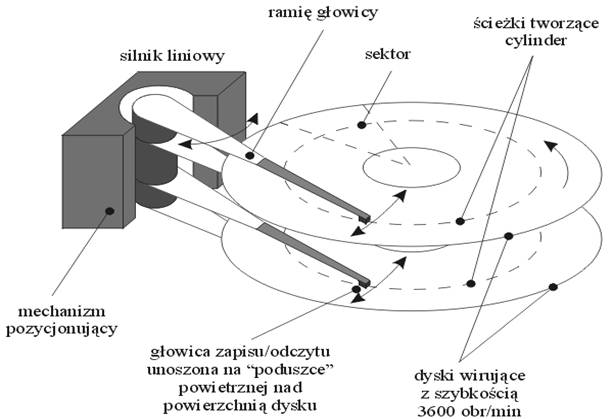

Dysk stały naszego PC to wirujący talerz lub zespół talerzy o powierzchni pokrytej nośnikiem magnetycznym, a odpowiednio ustawiane na tych powierzchniach głowice zapisują i odczytują dane. Głowice umieszczone są na przypominającym ramię gramofonu ramieniu pozycjonującym i dociskane do powierzchni dysku sprężynami, ale podczas obrotów dysku nie stykają się z nią powstająca w wyniku szybkich obrotów talerzy poduszka powietrzna utrzymuje głowice nad powierzchnią. Rozwiązanie takie nazywane jest pływającymi głowicami i jak na razie jest bezkonkurencyjne i stosowane powszechnie, chociaż są już w toku prace nad innymi sposobami prowadzenia głowic.

Jak już wspomniałem, głowice dysku są zamontowane na konstrukcji obrotowej, budzącej skojarzenie z ramieniem gramofonu. Słuszne optycznie skojarzenie nie jest jednak prawdziwe. Podczas gdy ramię gramofonu było prowadzone przez ścieżkę zapisu na płycie, to z ramieniem głowic dysku jest zupełnie inaczej musi ono być ustawione tak, by głowice znalazły się nad odczytywaną właśnie ścieżką (czy raczej na odczytywanym cylindrze). W pierwszych konstrukcjach dysków sztywnych pozycjonowanie głowic było realizowane przez mechanizm napędzany silnikiem krokowym (rozwiązanie takie jest do dziś stosowane w napędach dyskietek). W miarę wzrostu wymagań szybkościowych stosowano inne rozwiązania, spośród których optymalnym jak na razie okazało się voice coil, czyli układ magnetodynamiczny, wzorowany na stosowanym w głośnikach (stąd nazwa) umieszczona w polu silnego magnesu stałego cewka porusza się zgodnie z przepływającym przez nią prądem, ustawiając w odpowiedniej pozycji związane z nią mechanicznie ramię głowic dysku. Technika ta pozwoliła na zmniejszenie czasu pozycjonowania głowic na zadanej ścieżce z kilkudziesięciu do kilku milisekund, a przy przejściach pomiędzy kolejnymi ścieżkami nawet poniżej jednej milisekundy.

Tradycyjnie w komputerze PC AT adresowanie dysku przez przerwanie 13 BIOS-u (INT 13) odbywało się za pomocą trzech parametrów: cylindra, głowicy i sektora (tzw. adresowanie CHS od słów Cylinder, Head, Sector). Konwencjonalne funkcje INT 13 używały 24 bitów do reprezentacji adresów, zatem możliwe było jedynie zaadresowanie obszaru o pojemności 8,4 GB (224×512 bajtów/sektor = 8,4 GB). W celu przekroczenia tej granicznej wartości producenci wprowadzili dwa nowsze sposoby (stosowane właśnie w dzisiejszych dyskach) adresowania.

Pierwszy polegał na rozszerzeniu reprezentacji adresu w konwencji CHS do 32 bitów, drugi częściej stosowany używał zupełnie odmiennej metody noszącej nazwę LBA. W metodzie LBA (Logical Block Addressing) stosowane jest adresowanie 28-bitowe, co pozwala na zaadresowanie obszaru do granicznej (znowu!) pojemności wynoszącej: 228×512 bajtów/sektor = 137,4 GB. Jest to wartość jak na razie nieosiągalna dla przeciętnego posiadacza komputera (dla producentów owszem; nie tak dawno Quantum poinformowało o wyprodukowaniu dysku o pojemności ponad 200 GB!). Ten właśnie tryb adresowania jest zalecany i zaimplementowany w BIOS-ach większości dzisiejszych PC-tów.

Zapis na dysku dokonywany jest w formie koncentrycznych ścieżek, podzielonych na sektory. Dość tajemnicze pojęcie cylinder, występujące w opisie parametrów dysku i nie znajdujące bezpośredniego odbicia w jego konstrukcji, to grupa ścieżek o tym samym numerze na wszystkich powierzchniach roboczych. Liczba głowic odpowiada liczbie roboczych powierzchni talerzy dysku.

Taki opis parametrów fizycznych dysku oraz wynikający z niego tryb adresowania stanowiły pierwotnie podstawę rozumienia zapisu na dysku przez wszystkie systemy operacyjne. Opis CHS (cylinder/head/sector) sprawdzał się bardzo dobrze w czasach, gdy całością procesu zapisu i odczytu danych zarządzała jednostka centralna przy współudziale dość prymitywnego sterownika. Nietrudno jednak zauważyć, że całkowita długość pierwszej, najbardziej zewnętrznej ścieżki jest znacznie większa od długości ostatniej, najbliższej osi talerza. Liniowa gęstość zapisu jest stała dla wszystkich ścieżek (po prostu maksymalna), a przy stałej liczbie sektorów na każdej kolejnej ścieżce (licząc od ostatniej do pierwszej) marnowałaby się coraz większa ilość miejsca. Dlatego już od dość dawna stosuje się technikę MZR (Multiple Zone Recording), maksymalnie wykorzystującą dostępną powierzchnię talerzy liczba sektorów w ostatnim cylindrze dysku, wynikająca z liniowej gęstości zapisu, pozostaje stała w kolejnych cylindrach do chwili, gdy ilość wolnego miejsca pozwoli na dodanie jednego sektora więcej. Na dysku powstają w ten sposób kolejne strefy, charakteryzujące się rosnącą liczbą sektorów w miarę zbliżania się do krawędzi talerza.

W początkowym okresie stosowania MZR praktykowano technikę przeliczania geometrycznej lokalizacji danych na logiczne parametry systemu CHS. Wymagało to dość kłopotliwego, ręcznego wprowadzania parametrów przeliczeniowych konkretnych modeli dysków do pamięci konfiguracji systemu (tzw. Setup). Od problemu indywidualnych parametrów dysków uwolniły nas dopiero: z jednej strony rozwój interfejsu ATA, dzięki któremu system był w stanie samodzielnie odczytać z dysku i przyjąć do wiadomości przeliczeniowe parametry, z drugiej zaś wprowadzenie BIOS-u funkcji obsługi trybu LBA (Logical Block Addressing), uniezależniającego adresowanie danych na dysku od ich fizycznej lokalizacji na nim.

a) Głowice

Głowice magnetorezystywne :

Twardy dysk ze swoimi maleńkimi elementami wykonanymi z dokładnością przy której, zegarmistrzowska precyzja przypomina raczej kowalską robotę to w istocie arcydzieło technologii. Prawdziwym cudem jest jednak głowica. W nowoczesnych konstrukcjach stosuje się tak zwane głowice magnetorezystywne.

Gwoli ścisłości powinno się raczej używać określenia hybrydowe do zapisu danych służy elektromagnetyczna głowica cienkowarstwowa (jej mikroskopijna ceweczka ma około 10 zwojów), głowica magnetorezystywna służy do odczytu. Wykorzystuje ona efekt zmiany oporności elektrycznej specjalnego materiału (stop żelaza i niklu) przy zmianie pola magnetycznego i jest o wiele czulsza od głowicy elektromagnetycznej. Pozwala to znacznie zmniejszyć powierzchnię zajmowaną przez każdy bit informacji, a więc zwiększyć gęstość zapisu. Współczesne dyski charakteryzują się gęstością rzędu 1 gigabita na cal kwadratowy, zaś w laboratoriach IBM (to właśnie w nich stworzono pierwsze głowice magnetorezystywne) osiągnięto w grudniu 1996 roku gęstość 5 gigabitów na cal kwadratowy.

Przy tej gęstości na jednym calu długości ścieżki mieści się 240 tysięcy bitów, na jeden cal promienia dysku przypada 21 tysięcy ścieżek, a jeden bit zajmuje powierzchnię 1,2 na 0,1 mikrometra (przekrój ludzkiego włosa zmieściłby około 1000 bitów). Dzięki doskonaleniu technologii GMR (Giant Magnetoresistive Effect) naukowcy przewidują osiągnięcie przed końcem wieku gęstości 10 Gb na cal kwadratowy.

Pozycjonowanie głowicy:

Kiedyś na potrzeby nawigacji zarezerwowana była cała jedna powierzchnia dysku, na której zapisane były znaczniki ścieżek i sektorów dla pozostałych głowic system taki nazywał się dedicated servo. Dzisiejsze napędy wykorzystują technologię embedded servo znaczniki umieszczone są na powierzchniach roboczych i przemieszane z obszarami danych. Wiąże się to co prawda z przydzieleniem elektronice dysku dodatkowych zajęć, pozwala jednak zwiększyć efektywną pojemność urządzenia. W celu uniknięcia błędów odczytu głowica musi znajdować się dokładnie nad środkiem danej ścieżki. Nie jest to wcale łatwe zadanie, gdyż pod wpływem ciepła materiał, z którego wykonane są płyty dysku, może ulec odkształceniom. W odróżnieniu od tradycyjnej techniki Servo, przy której głowica musiała regularnie korzystać ze ścieżki sterującej, aby zoptymalizować swoją pozycję, mechanizm Embedded Servo wykorzystuje informacje sterujące zapisane na każdej ścieżce. Głowice zapisująco odczytujące mogą więc korzystać z nich przez cały czas, co umożliwia dokładniejsze pozycjonowanie. Technika Embedded Servo działa na podobnej zasadzie, jak automatyczny pilot, który nieprzerwanie dba o utrzymanie właściwego toru lotu.

Stosowana dawniej okresowa kalibracja głowicy dysku powodowała natomiast dodatkowe przerwy w transmisji danych.Inteligentne układy sterujące pozwoliły także zmienić sposób przesuwania głowicy nad szukaną ścieżkę niegdyś służyły do tego stosunkowo powolne i zawodne silniczki krokowe (do dziś używane w stacjach dyskietek zdradzają swą obecność charakterystycznym burczeniem), teraz delikatne jak piórko kolibra ramię głowicy wychylane jest na podobieństwo wskazówki miernika elektrycznego za pomocą cewki, przez którą przepływa prąd o odpowiednio dobranym natężeniu (tzw. voice coil) dzięki temu średni czas dostępu do danych to dziś 10 lub mniej milisekund. Niektóre firmy stosują technologię Read on Arrival, wykorzystującą mechanizm korekcji błędów pierwsza próba odczytu podejmowana jest jeszcze zanim głowica ustabilizuje się nad żądaną ścieżką; albo próba się powiedzie, albo skutecznie zadziała mechanizm korekcji błędu odczytu, w najgorszym przypadku trzeba będzie ponowić odczyt nic do stracenia, a można zyskać cenne milisekundy.

Odległość głowicy od nośnika (ok. 2 milionowych części cala), jest o wiele mniejsza od średnicy ludzkiego włosa, przez tak wąską szczelinkę nie przechodzi nawet światło! Aby umożliwić dostęp do poszczególnych ścieżek, zawieszone obrotowo ramię wychyla się na podobieństwo wskazówki miernika, poruszane polem cewki magnetycznej układ taki, zwany voice coil, zapewnia szybkość ruchu dużo większą od stosowanych w pierwszych konstrukcjach silniczków krokowych.

b) Kodowanie

Kodowanie danych:

Zapis danych binarnych w formie magnetycznej nie jest dokonywany bezpośrednio bit w bit dane przeznaczone do zapisu są kodowane według pewnych algorytmów, których zadaniem jest usprawnienie odczytu, a także zapewnienie większej jednoznaczności zapisu. Kodowanie danych przeznaczonych do zapisu składa się z dwu faz najpierw do zapisywanych danych dodawane są dane nadmiarowe umożliwiające detekcję i korektę ewentualnych błędów odczytu (CRC Cyclic Redundancy Code najprostszy, a zarazem jeden z najefektywniejszych algorytmów wprowadzania danych nadmiarowych dla celów korekcji błędów), następnie zaś wynikowe wartości są przekształcane tak, by uniknąć powtarzania dłuższych ciągów powtarzających się zer czy jedynek.

Historycznie pierwszym systemem kodowania danych był MFM dziś już zupełnie nie stosowany, wyparty następnie przez kodowanie RLL (Run Lenght Limited) stosowane w dyskach sztywnych do niedawna, a wciąż jeszcze używane przy zapisie na dyskietkach. Obecnie powszechnie stosowaną techniką kodowania danych na dysku jest PRML (Partial Response Maximum Likelihood) która zapewnia największą efektywną gęstość zapisu, a także najniższą stopę błędu odczytu danych. Technika PRML wymaga stosowania w układach sterujących dysku specjalizowanych procesorów o dużej mocy, jednak technologie krzemowe są obecnie na tyle tanie, że uzyskiwane dzięki nim zwiększenie gęstości zapisu z nawiązką wyrównuje nieco wyższy koszt wbudowanej w dysk elektroniki.

c) MZR

Nietrudno zauważyć, że w wyniku podziału każdej ścieżki na stałą liczbę sektorów, sektory znajdujące się dalej od osi dysku będą znacznie dłuższe (długość sektorów wewnętrznych jest ograniczona od dołu maksymalnym upakowaniem bitów na jednostkę powierzchni). Aby zapobiec ewidentnemu marnotrawstwu, podzielono dysk na kilka stref o określonej liczbie sektorów (od 60 do 120 sektorów na ścieżkę), coraz większej dla stref bliższych obwodowi dysku. Zysk jest ewidentny (o około 25% większa pojemność i wydajność), przy okazji wychodzi na jaw drobne oszustwo: jak to się ma do liczby sektorów na ścieżkę deklarowanej w Setupie BIOS? Ano, BIOS mówi swoje, a elektronika dysku po cichu dokonuje przeliczeń

Mało tego, wewnątrz dysku dzieje się jeszcze coś, o czym ani użytkownik, ani system operacyjny nie mają zielonego pojęcia. Chodzi mianowicie o system obsługi błędów. Oczywiście, dane zapisywane na dysku wyposażone są w dodatkowe informacje umożliwiające funkcjonowanie systemu korekcji w locie (ECC on the fly, kodowanie Reed-Solomon itd). Oprócz tego jednak na każdej ścieżce zarezerwowana jest pewna liczba sektorów, które w przypadku pojawienia się fizycznych uszkodzeń nośnika podstawiane są przez wewnętrzny mikroprocesor napędu zamiast sektorów wadliwych dzieje się to całkowicie niezauważalnie dla świata zewnętrznego. Notabene, wewnętrzne układy mikroprocesorowe, w które wyposażone są współczesne napędy, mają moc przetwarzania porównywalną z co najmniej z IBM PC/AT.

d) PRML

PRML (Partial Response Maximum Likelihood):

Większość napędów jeszcze do niedawna podczas odczytu danych używała techniki zwanej peak detection (wykrywanie wartości ekstremalnych maksimum siły sygnału). W miarę wzrostu gęstości zapisu rozróżnienie sąsiednich wartości szczytowych sygnału od siebie nawzajem i od tzw. tła stawało się coraz trudniejsze. Problem ten rozwiązywano wstawiając pomiędzy sąsiadujące szczyty (jedynki) rozdzielające chwile ciszy (zera). Takie postępowanie sprowadzało się do kodowania zerojedynkowych ciągów za pomocą ciągów bardziej przejrzystych, czyli łatwiej identyfikowalnych, lecz z konieczności dłuższych. To oczywiście obniżało efektywną gęstość zapisu danych, a w konsekwencji także wydajność napędu.

Z pomocą przyszła opracowana na potrzeby długodystansowej komunikacji w przestrzeni kosmicznej technologia PRML (Partial Response Maximum Likelihood). Pochodzący z głowicy odczytującej analogowy sygnał jest próbkowany w wielu miejscach, a następnie cyfrowo filtrowany przez wbudowany w elektronikę dysku dedykowany procesor sygnałowy DSP. Uzyskaną w ten sposób próbkę analizuje się algorytmem Viterbi. Sprawdza on wszystkie kombinacje danych, które mogły wygenerować zbliżony ciąg i wybiera tę najbardziej prawdopodobną. Umożliwia to dodatkowe zwiększenie czułości kanału odczytu i istotne zmniejszenie prawdopodobieństwa wystąpienia błędów odczytu. Najlepsze efekty daje połączenie technologii PRML z magnetorezystywną głowicą odczytującą ze względu na dobrą jakość generowanego przez nią sygnału analogowego. Głowica magnetorezystywna (MRH) wykorzystuje inne zjawisko fizyczne niż głowice, zbliżone konstrukcją do stosowanych w zwykłych magnetofonach. Element czytający MRH jest wykonany z substancji zmieniającej oporność w polu magnetycznym, więc namagnesowanie nośnika bezpośrednio rzutuje na natężenie płynącego przez głowicę MR prądu. Istotną zaletą technologii MR jest większa czułość, pozwalająca na radykalne zwiększenie gęstości zapisu, a co za tym idzie wzrost pojemności napędu przy zachowaniu jego rozmiarów.

PRML oznacza także inną metodę kodowania danych na dysku: o ile przejście ze starej metody MFM (Multiple Frequency Modulation) na bardziej zaawansowaną RLL (Run Length Limited) oznaczało wzrost upakowania danych o około 50%, PRML daje tu kolejne 20-40% zysku (różne źródła podają różne wartości).

e) Zapis magnetyczny

Napęd różni się od innych pamięci (jak np. RAM czy Cache wykonanych przeważnie z półprzewodnikowych obwodów elektrycznych) tym, że składa się z wielu mniej lub bardziej skomplikowanych części mechanicznych. Jedną z konsekwencji tego faktu jest naturalny proces zużywania się napędów, co po dłuższej eksploatacji prowadzi do błędów w zapisie i odczycie, a nawet do całkowitej niesprawności. Inaczej jest w przypadku elektronicznych nośników pamięci, które nie zużywają się w normalnej eksploatacji, tylko w wyniku niewłaściwego obchodzenia się z nimi. Urządzenie składające się z mechanicznych i obracających się części, jakim jest każdy twardy dysk wrażliwe jest na działanie takich czynników zewnętrznych, jak upuszczenie czy wstrząsy w czasie pracy i może w ich wyniku zostać poważnie uszkodzone.

Techniki zapisu magnetycznego:

Wśród napędów rozróżnia się dwa zasadniczo różne sposoby zapisu, a więc i odczytu informacji: magnetyczny jak w przypadku twardych dysków. W każdym pececie znajduje się specjalny kontroler napędów, które z reguły steruje zarówno napędem dyskietek jak i dyskiem twardym (jednym lub kilkoma). Cyfrowe (zerojedynkowe) informacje przeznaczone do zapisu trafiają do kontrolera. Następnie zamieniane są w impulsy magnetyczne, a dokładniej, zmienia się kierunek przepływu prądu w cewce powodując zmianę bieguna pola magnetycznego, aby mogły być zapisane na magnetycznej powierzchni twardego dysku. Nie wystarczy jednak przy tym zapisywać dane bity jeden po drugim, trzeba dodatkowo zaznaczyć gdzie dany bit się zaczyna, a gdzie kończy. Może się to dziać na kilka różnych sposobów:

FM Frequence Modulation

MFM Modified Frquence Modulation

RLL Run Length Limited

ARLL Advanced Run Length Limited

Metoda FM:

W tej na najstarszej technice każdej jedynce odpowiada zmiana biegunowości pola magnetycznego, natomiast przy zerze pozostaje ona niezmieniona. Początek każdego bitu (obojętnie zero czy jedynka) wymaga dodatkowo tzw. sygnału taktującego, czyli dodatkowej zmiany biegunowości. Tak, więc do zapisu 1 potrzeba dwu zmian biegunowości, a do 0 jednej (tylko początek taktu).

Metoda ta nie wykorzystuje optymalnie miejsca na twardym dysku, gdyż wymaga zbyt wielu zmian biegunowości. Im mniej tych zmian, tym więcej danych można zmieścić na tej samej powierzchni. Metoda ta jest już dosyć przestarzała i używana jest właściwie tylko przez stary format dyskietki IBM.

Metoda MFM:

Lepsze wykorzystanie miejsca na dysku umożliwia zmodyfikowana metoda modulacji częstotliwości MFM. Sygnał taktujący został tutaj niejako przejęty przez strumień informacji. Rozwiązanie to zakłada jednak stałą prędkość obrotową dysku, tylko wtedy każdemu bitowi przyporządkowany jest taki sam, co do wielkości obszar. W technice MFM zmiana biegunowości odbywa się dla każdej jedynki tylko w środku danego obszaru, natomiast każde zero rozpoczyna się na początku takiego obszaru, ale tylko wtedy, gdy wcześniejszy bit nie był jedynką. Oznacza to 100% wzrost gęstości zapisu w stosunku do metody FM. Przez wiele lat była to najczęściej stosowana technika zapisu na twardych dyskach. Współpracowały one z kontrolerami w standardzie ST506/412, który umożliwiał zapis w 17 sektorach po 512 bajtów w każdym. Standard ten stosowany jest ciągle w spotykanych obecnie napędach dyskietek 3,5 i 5,25.

Metoda RLL:

Dalsze zagęszczenie zapisu, czyli zmniejszenie ilości zmian biegunowości pola magnetycznego na jednostkę informacji, przyniosła metoda kodowania informacji. Pewnym grupom bitów przyporządkowano kod o zmiennej długości. Odkodowanie następowało według następującej zasady:

Pomiędzy dwoma jedynkami znajdować się musi zawsze określona liczba zer.

Procedura ta a istnieje cały ich szereg nazywana jest metodą RLL

Np. w metodzie RLL2.7 pomiędzy dwie jedynki wstawianych jest od 2-7 zer, zas w RLL 3.9, znanej również pod nazwą ARLL (Advanced RLL), od 3 do 9.

Twarde dyski IDE i SCSI wykorzystują zwykle procedurę RLL1.7 lub jakąś jej odmianę. Tabel 2.1 pokazuje przyporządkowanie konkretnym grupom bitów (jest ich tylko siedem) kodów w procedurze RLL2.7. Procedura RLL2.7 pozwala na 50% zwiększenie pojemności twardych dysków w porównaniu z metoda MFM, na każdej ścieżce zmieści się bowiem 26 a nie 17 sektorów. Procedura RLL3.9 zwiększa te pojemność już o 100% (34 sektory na każdej ścieżce).

Wydajność:

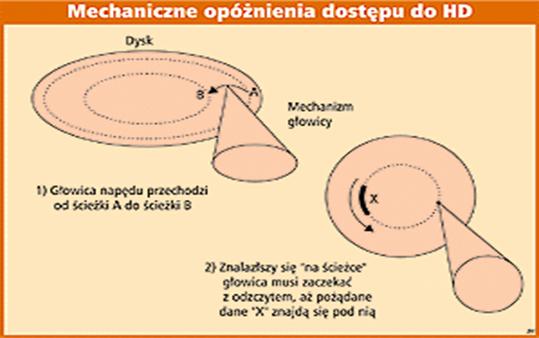

Wydajność dysku twardego jest na tyle istotna dla szybkości pracy całego systemu, że w praktyce dysk twardy jest wąskim gardłem w szybkości przetwarzania danych wewnątrz PC. Twardziele mimo wciąż rozwijanej szybkości transferu danych pozostają najwolniejszymi urządzeniami wewnątrz komputera (nie bierzemy pod uwagę napędów nośników wymiennych: dyskietek i płyt CD). Szybkość pracy dysku jest nadal dużo mniejsza niż np. pamięci RAM. Zapoznamy się bliżej z czynnikami decydującymi o wydajności twardziela po to, aby móc wybrać optymalny, czyli dysk pojemny, wystarczająco szybki, a do tego za przystępną cenę. Połączenie obrotowego ruchu talerzy z wahadłowym (w płaszczyźnie poziomej) ruchem ramienia głowicy daje możliwości dotarcia do każdego fragmentu nośnika. Logiczną konsekwencją takiego rozwiązania jest to, że czas odczytu danych, a tym samym wydajność dysku twardego zależy od: szybkości obrotowej talerzy, czasu pozycjonowania głowic, do tego dochodzi jeszcze czas przełączania głowic oraz czas potrzebny na przygotowanie głowicy do operacji odczytu/zapisu z żądanego sektora. Łączny czas wykonania tych operacji jest tzw. czasem dostępu do danych (ang. access time). Podawany przez niektórych producentów czas wyszukiwania (seek time) nie oznacza tego samego! Przez wyszukiwanie należy rozumieć czas, po jakim głowica odnajdzie właściwą ścieżkę, jednak pomijany jest czas potrzebny na lokalizację odpowiedniego sektora na tej ścieżce oraz czas przełączania głowic i przygotowania do operacji odczytu/zapisu. Tymczasem opóźnienia wprowadzane przez te zadania mogą decydować o tym, jak szybko dane odczytane z dysku trafią do pamięci komputera.

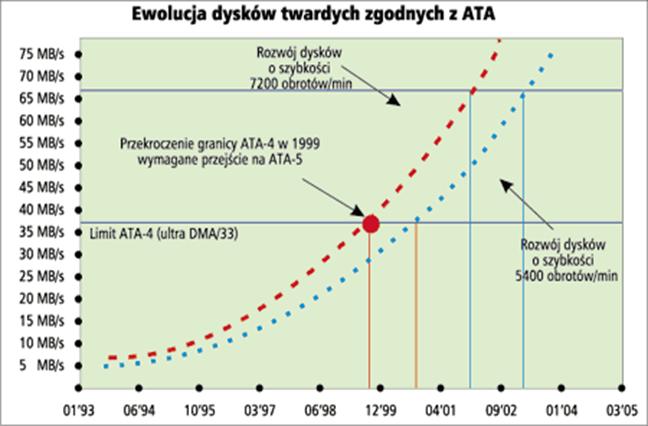

Oprócz wyżej wymienionych parametrów istotnym składnikiem wydajności dysku jest gęstość zapisu Im więcej bitów daje się upakować na pewnym obszarze nośnika, tym więcej danych można odczytać, przy niezmienionych pozostałych parametrach (szybkość obrotowa, czas wyszukiwania ścieżki itp.). Zwróćmy uwagę, że od dłuższego czasu dyski ATA dostępne są w dwóch klasach. Pod względem szybkości obrotowej talerzy dzielą się na dwie kategorie: 5400 obr./min i 7200 obr./min. Mimo to, aktualnie produkowane dyski klasy ekonomicznej pracujące z prędkością obrotową 5400 obr./min uzyskują w testach większy transfer niż wydajnościowe dyski 7200 obr./min sprzed około roku. Lepsze rezultaty wolniej obracających się dysków (ale nowszych) to zasługa właśnie odpowiednio wyższej gęstości zapisu. Dlatego gdy zależy nam na wydajności dysku, to porównując parametry, bierzemy pod uwagę dyski wyprodukowane mniej więcej w tym samym czasie, w przeciwnym razie możemy się nieco oszukać. Jak ocenić wiek dysku? Na ogół sposób jest bardzo prosty, wystarczy sprawdzić datę produkcji umieszczoną na nalepce znamionowej dysku.

To czy szybkość pracy dysku twardego istotnie podniesie komfort pracy, zależy głównie od tego, jakiego typu prace wykonujemy za pomocą komputera. Nie da się zaprzeczyć, ze szybki dysk da odczuwalną (na korzyść) różnicę w następujących operacjach: uruchamianie się systemu (kiedy z dysku twardego ładowane są poszczególne komponenty systemu operacyjnego) oraz odczyt i zapis dużych plików (np. sekwencje wideo, nieskompresowane obrazy wysokiej rozdzielczości, wysokiej jakości nieskompresowany dźwięk itp.). dlatego, gdy zajmujemy się obróbką grafiki, nieliniowym montażem wideo czy obróbką dźwięku, powinniśmy zdecydować się na jak najszybszy model. Jeżeli jednak wspomniane zadania wykonujemy sporadycznie, a komputera używamy głównie do tworzenia dokumentów o małej objętości (typowe zadnia biurowe, tworzenie listów, prezentacji, obliczenia w arkuszach kalkulacyjnych itp.) lub do gier, kupowanie jak najszybszego dysku nie ma ekonomicznego sensu, bo wolniejsze dyski klasy 5400 obr./min w zupełności temu sprostają.

Parametry:

Podstawowe parametry dysku sztywnego są takie same, jak dla każdego innego rodzaju pamięci. Jest to pojemność, czas dostępu do danych oraz szybkość ich odczytu i zapisu. Do parametrów podstawowych dochodzi szereg parametrów i informacji szczegółowych, pozwalających na precyzyjne określenie zarówno przeznaczenia dysku, jak i jego zachowania w konkretnych warunkach eksploatacji.

a) Pojemność

Przeglądając oferty lub informacje dystrybutorów i producentów dysków twardych niejednokrotnie dokonujemy wyboru na podstawie parametrów, jakie przedstawia dana specyfikacja. Tymczasem w przypadku pojemności informacja podawana na ulotce nie do końca musi odpowiadać temu, co zobaczymy po sformatowaniu dysku w naszym komputerze. Po pierwsze, dość często spotykanym wybiegiem marketingowym jest podawanie pojemności danego dysku w mega- lub w gigabajtach, z zastrzeżeniem, że 1 MB to 1 000 000 bajtów, a 1 GB to 1 000 000 000 bajtów. Tymczasem stan faktyczny jest inny 1 kB równy jest 1024 bajtom, a nie 1000 bajtom. Różnica nie jest co prawda wielka, ale przy olbrzymich pojemnościach dzisiejszych dysków te zaokrąglenia powodują, że różnica pomiędzy informacją producenta a wynikiem formatowania dysku w komputerze może okazać się zaskakująca dla nieświadomego takiej polityki użytkownika. Przykładowo dla dysku o pojemności (przy przeliczniku 1 kB = 1000 B) 18 042 MB otrzymamy, że dysk dysponuje faktyczną pojemnością ok. 17206,20 MB. Jak więc widać różnica sięga ponad 800 MB, co jeszcze nie tak dawno stanowiło całkowitą pojemność dysku twardego! Dlatego też dokonując wyboru musimy pamiętać o tym, w jaki sposób megabajty czy gigabajty są podawane w informacjach producenta.

b) Czas dostępu

Podstawowym handlowym, najbardziej eksponowanym parametrem dysku jest, poza pojemnością, czas dostępu do danych Czas dostępu to czas pozycjonowania głowic plus średnio pół obrotu dysku (bo zawsze jest możliwa sytuacja, gdy poszukiwany sektor znalazł się pod głowicą, zanim była gotowa do odczytu), zatem na czas dostępu wpływa zarówno sprawność mechanizmu pozycjonowania głowic, jak i prędkość obrotowa dysku. Typowy średni czas pozycjonowania głowic to 3-6 ms, a pół obrotu dysku, wykonującego np. 7200 obr./min to około 4 ms razem, dodając jeszcze czas przełączania głowic, uzyskujemy 8-11 ms.

Czas dostępu jest szczególnie ważny w obsłudze baz danych, gdzie występuje często bezpośrednie adresowanie danych plikowych. Ale użytkowo najważniejszym z parametrów dysku jest tzw. transfer wewnętrzny, czyli szybkość bezpośredniego odczytu i zapisu danych. Dlaczego najważniejszym? Rozważmy następujący, bardzo uproszczony, przykład: zadanie polegające na odczytaniu 20 plików po 100 kB każdy w przypadku dwu dysków: jednego o średnim czasie dostępu 10 ms i transferze wewnętrznym 2 MB/s, drugiego o czasie dostępu 7,5 ms (o 25% szybciej!) i transferze wewnętrznym 1,8 MB/s (o zaledwie 10%). Pierwszy z dysków jest w stanie wykonać zadanie w czasie 1200 ms, drugi z nich potrzebuje na to samo zadanie 1261 ms, o przeszło 5% więcej. A ponieważ najbardziej eksponowanym z parametrów jest czas dostępu, ten drugi dysk będzie na pewno sporo droższy, pomimo gorszej wydajności. Transfer wewnętrzny jest stosunkowo rzadko podawany, natomiast dla zwiększenia zamieszania, a także w celu oszołomienia klienta wielkimi liczbami, mocno eksponowanym parametrem dysku jest zwykle szybkość interfejsu, której wpływ na rzeczywistą wydajność systemu jest obecnie marginalny. Odwołując się do naszego przykładu - do przetransmitowania 2 MB danych interfejs SCSI-2 o przepustowości 20 MB/s potrzebuje 100 ms, interfejs Ultra ATA-66 zaledwie 33 ms, ale w obu przypadkach czas transmisji przez interfejs i tak zawarty jest w ogólnym czasie operacji i praktycznie nie ma wpływu na końcowy rezultat.

Skąd wobec tego potrzeba przyspieszania interfejsów, skoro szybkość transmisji wydaje się nie mieć wpływu na ogólną efektywność? Odpowiedź transmisja przez interfejs zajmuje szynę PCI, przez którą interfejs współpracuje z jednostką centralną, zmniejszając jej dostępność dla innych ewentualnie wykonywanych procesów. W przypadku bardziej zaawansowanych systemów operacyjnych ma to spory wpływ na ogólną wydajność systemu, ale np. w jednozadaniowym środowisku DOS, a także w trybach wielozadaniowych, stosowanych w Windows 95/98, nie ma praktycznie prawie żadnego znaczenia.

Czas dostępu oznacza ile jednostek (Ms) potrzebuje dysk na pobranie danych. Czas mierzony jest od momentu wydania przez interfejs polecenia odczytu danych. Wartość średniego czasu dostępu jest sumą średniego czasu wyszukiwania (Average Seek Time, czyli czasu potrzebnego na ustawienie głowicy w odpowiednim miejscu nad talerzem twardego dysku) oraz średniego czasu opóźnienia (Average Latency Time czasu potrzebnego sektorowi do znalezienia się pod odpowiednia głowicą).

Producenci w swoich informacjach o produkcie podają zwykle jedynie średni czas wyszukiwania (Average Seek Time) wartość ta określa wyłącznie czas potrzebny na ustawienie głowicy nad odpowiednią ścieżką dysku. Stad wartości podawane w opisie dysku są często tak obiecujące. Warto jednak pamiętać, że czas wyszukiwania jest zawsze krótszy od czasu dostępu, z którym nie należy go mylić.

Wartość Track-to-Track nie mówi niczego o twardym dysku. Miara ta podaje czas potrzebny na przesunięcie głowicy zapisująco odczytującej nad sąsiednią ścieżkę.

c) Liczba talerzy

Liczba talerzy określa liczbę talerzy danego dysku. Uwaga! Liczba talerzy nie oznacza, że dane zapisywane są zawsze po obu stronach talerza dysku. Informację na ten temat otrzymamy porównując liczbę talerzy z liczbą głowic danego dysku.

d) Liczba głowic

Liczba głowic określa, ile głowic zajmuje się odczytem/zapisem danych na talerzach. Liczba ta wskazuje także na to, czy wszystkie talerze są wykorzystywane obustronnie. Parzysta liczba głowic wskazuje na to, że dane mogą być przechowywane na każdej stronie każdego talerza dysku, natomiast nieparzysta że jedna strona któregoś z talerzy dysku nie jest w ogóle wykorzystywana.

e) Transfer wewnętrzny

Transfer wewnętrzny parametr ten określa w praktyce rzeczywisty transfer danego dysku. Im wartość ta jest wyższa, tym dany dysk jest szybszy. Jednak o tym, czy w danym komputerze będzie osiągał optimum swoich możliwości decyduje konfiguracja komputera (włączenie trybu DMA itp.).

Wewnętrzna szybkość przesyłania danych :

Informuje o ilości danych, jaka może zostać na twardym dysku zapisana lub odczytana z dysku w ciągu sekundy. Jest to wartość teoretyczna, niezależna od systemu operacyjnego oraz wszelkich właściwości komputera, określająca wydajność wewnętrzną dysku. Mierzona jest ona dla sektorów znajdujących się miedzy krawędzią płyty, a jej środkiem, jako że w zewnętrznej części płyty znajduje się więcej sektorów aniżeli w części bliższej środka.

Jeśli wartość ta nie jest podana w danych technicznych o twardym dysku, można ja obliczyć: liczbę obrotów na sekundę należy pomnożyć przez liczbę sektorów znajdujących się na najbardziej zewnętrznej ścieżce i tak uzyskana wartość pomnożyć przez 512, jako ze tyle bajtów zawiera jeden sektor. Wartości tej nie da się zmierzyć za pomocą testów, gdyż dokonanie pomiarów możliwe jest tylko przy użyciu odpowiednich urządzeń.

Przykład: Twardy dysk do komputera do biura i domu powinien charakteryzować się wewnętrzna szybkością przesyłania danych większą od 140 Mb/s. Komputer multimedialny najlepiej wyposażyć w dysk pozwalający na przesyłanie 160 Mb/s, a komputer high-end - w dysk o szybkości 180 lub więcej Mb/s.

Niektórzy producenci podczas obliczania wewnętrznej szybkości przesyłania danych, jako dane liczą również dane administracyjne (takie jak numer sektora, nad który głowica ma być przesunięta i suma kontrolna) uzyskując dzięki temu wartość o 12 do 20 procent wyższą. Stad pochodzić może ewentualna różnica miedzy wartością wewnętrznej szybkości przesyłania danych obliczona samodzielnie, a podana przez producenta.

f) Średni czas dostępu

Średni czas dostępu parametr ten określa, w jakim czasie (średnio) od otrzymania przez dysk żądania odczytu/zapisu konkretnego obszaru nastąpi rozpoczęcie operacji. Im krótszy jest ten czas, tym dysk może zapewnić większą płynność odtwarzania, co może mieć znaczenie np. podczas nagrywania płyt CD-R/CD-RW, gdzie wymagany jest ciągły dopływ danych.

g) Transfer zewnętrzny

Transfer zewnętrzny właśnie ten parametr często jest używany w marketingowych określeniach i notatkach producentów. Tymczasem nie określa on faktycznej szybkości dysku, lecz przepustowość interfejsu. Oczywiście im ten parametr jest wyższy, tym lepiej warto jednak pamiętać, że dyski o takim samym transferze zewnętrznym mogą w praktyce pracować z różną szybkością.

h) Liczba obrotów na min

Liczba obrotów na min parametr określający, z jaką szybkością obracają się talerze danego dysku. Im szybkość obrotowa jest wyższa, tym więcej danych może być odczytywanych przez głowice. Pamiętajmy jednak, że ten parametr należy oceniać biorąc pod uwagę także gęstość zapisu. W praktyce jednak przy porównywaniu dysków o podobnej pojemności te z większą szybkością obrotową są zazwyczaj szybsze.

i) Cache

Cache pamięć podręczna dysku twardego. Do tej pamięci buforowane są dane odczytywane i zapisywane na dysku. Im tej pamięci jest więcej, tym sprawniejszy jest proces przesyłu danych.

j) MTBF

MTBF akronim od zwrotu Mean Time Between Failure, co można przetłumaczyć jako średni czas międzyuszkodzeniowy. Parametr ten podawany jest w godzinach. Choć wartości, z jakimi spotkamy się w tej tabeli wyglądają na olbrzymie, to należy pamiętać, że czas ten jest wartością średnią ustaloną na podstawie testów dysków danej serii. Warto wiedzieć, że istnieje niezerowe prawdopodobieństwo, że dany dysk ulegnie uszkodzeniu już w pierwszym roku użytkowania.

Średni czas międzyuszkodzeniowy (Mean Time Between Failures) to podstawowy parametr niezawodności wszystkich urządzeń. Oferowany przez większość współczesnych dysków współczynnik MTBF wynoszący 500 000 godzin lub więcej imponuje wielkością, zwłaszcza gdy po przeliczeniu dowiemy się, że pół miliona godzin to około 60 lat ciągłej pracy. Ale czy to naprawdę wysoka niezawodność? Pamiętajmy, że jest to czas średni, określony na podstawie analizy statystycznej wyników testów, a dotyczy całej serii danego modelu dysku.

Z punktu widzenia indywidualnego użytkownika ze współczynnika MTBF równego 500 000 godzin wynika aż 1,7% prawdopodobieństwa, że w bieżącym roku dysk ulegnie uszkodzeniu. Przy normalnym użytkowaniu komputer pracuje średnio 6 godzin w ciągu doby, zatem prawdopodobieństwo uszkodzenia będzie odpowiednio mniejsze rzędu 0,5%. Ujmując to w skali masowej, a nie tylko pojedynczego egzemplarza dysku co dwusetny dysk ulegnie w tym roku uszkodzeniu! Szansa uszkodzenia dysku jest o wiele rzędów wielkości większa od szansy wygranej w Lotto, a jednak spośród grających regularnie w Lotto użytkowników komputerów tylko nieliczni zawracają sobie głowę czymś tak surrealistycznym jak backup danych. Wiara w szczęście czy fascynacja wielkimi liczbami? Dla przeciętnego domowego użytkownika takie prawdopodobieństwo awarii zwykle jest do przyjęcia, zwłaszcza jeśli w kieszeni ma trzyletnią gwarancję, a na dysku nie przechowuje unikalnych wartościowych danych.

Ostatnio coraz więcej producentów podaje dla niektórych modeli dysków współczynnik MTBF rzędu miliona godzin i więcej. Liczby astronomiczne, ale zapewniające tylko dwukrotne zwiększenie szans użytkownika. Z możliwością uszkodzenia dysku należy się poważnie liczyć, jeśli używamy komputera nie tylko do zabawy, a na dysku przechowujemy wartościowe dane. A nawet w przypadku komputera rozrywkowego awaria dysku to poważny kłopot i wiele godzin pracy nad odtworzeniem konfiguracji aplikacji.

k) MBR

Podczas uruchamiania komputera najpierw odczytywana jest pamięć ROM (właściwie: FlashRom), w której zawarte są parametry BIOS-u.

Po zakończeniu tego pierwszego etapu uruchamiania komputera BIOS odczytuje i uruchamia program znajdujący się w pierwszym sektorze pierwszego dysku twardego lub na dyskietce (w zależności od tego, z jakiego nośnika korzystamy uruchamiając system).

Ów pierwszy sektor to właśnie Master Boot Record. Na początku tego sektora znajduje się mały program, zaś na końcu wskaźnik tablicy partycji. Program ten używa informacji o partycji w celu określenia, która partycja z dostępnych jest uruchamialna, a następnie próbuje uruchomić z niej system.

l) Pobór mocy

Pobór mocy zrozumienie tego parametru nie powinno sprawiać kłopotu, jednak jeżeli w naszym komputerze mamy stosunkowo słaby zasilacz, to może się okazać, że zakup dysku wymagającego stosunkowo dużo mocy może spowodować na komputerze, i tak już solidnie obsadzonym różnego typu sprzętem, przeciążenie zasilacza

m) interfejs ATA, macierz, IDE, SCSI

Interfejs:

Na pierwszy rzut oka wydawać by się mogło, że w konstrukcji PC używane są obecnie dwa typy interfejsów dyskowych: Ultra ATA i SCSI. Ale po przejrzeniu kilku katalogów sprzętowych opinia ulega zmianie, a w gąszczu nazw takich jak EIDE, ATAPI, Fast Wide SCSI i temu podobnych może się poczuć zagubiony nawet całkiem obyty fachowiec. Tyle jest standardów czy nie ma żadnego standardu?

Spróbuję trochę wyprostować kręte ścieżki w dżungli interfejsów dyskowych. Zacznijmy od początku, a na początku, wbrew temu co mówi Pismo, nie było chaosu. W PC był tylko jeden interfejs dyskowy, stworzony przez Seagate i określany jako ST-506/ST-412, od symboli pierwszych dwóch modeli dysków wyprodukowanych przez tę firmę.

Ze względu na niewygodę w posługiwaniu się tak abstrakcyjnym symbolem, żargonowo określano ten interfejs jako MFM lub RLL, od stosowanych w tych dyskach technik kodowania (nb. technika RLL jest stosowana przez niektórych producentów do dziś). Interfejs ten dawno odszedł do lamusa wraz z dyskami o pojemnościach kilkunastu megabajtów, wymagającymi złożonej logiki zewnętrznego sterownika. Jego los podzielił również ESDI (Enhanced Small Device Interface) pomimo niewątpliwych zalet okazał się zbyt kosztowny w stosunku do swojego konkurenta znanego jako IDE, który stał się pierwszym prawdziwym standardem.

IDE to znaczy ATA :

Konstrukcja komputera PC AT stworzyła możliwość zastosowania 16-bitowego interfejsu pomiędzy systemem a dyskiem oraz przeniesienia funkcji sterownika dysku do jego konstrukcji (dyski MFM-RLL były całkowicie głupie całość ich obsługi obciążała wchodzący w skład jednostki centralnej komputera sterownik). Powstał interfejs znany pod nazwami IDE i ATA, który dał początek rodzinie powszechnie stosowanych obecnie interfejsów dyskowych.

Integrated Drive Electronic (IDE to określenie techniki realizacji nowego interfejsu, w którym całość logiki sterownika dyskowego przeniesiono do konstrukcji dysku, ATA zaś to AT Attachment relacja nowego interfejsu do konstrukcji AT. Specyfikacja ATA została skodyfikowana przez ANSI jako oficjalny standard, definiując następujący zakres funkcji interfejsu:

pojedynczy kanał, dzielony przez dwa dyski, skonfigurowane jako master i slave;

komunikacja w trybach PIO 0, 1 i 2;

komunikacja przez DMA w trybach 0, 1, 2 dla transmisji pojedynczych słów i w trybie 0 dla transmisji multiword.

Standard ATA sprawdził się bardzo dobrze podbijając rynek, ale rosnące wymagania systemów spowodowały jego rozszerzenie do ATA-2, zaakceptowanego również oficjalnie przez ANSI. Nowe funkcje interfejsu ATA-2 to przede wszystkim:

szybsze tryby PIO ATA-2 wspomaga obsługę w trybach PIO 3 i 4;

obsługa multiword DMA w trybach 1 i 2;

rozkazy transmisji blokowych;

tryb LBA (Logical Block Addressing), umożliwiający, przy odpowiednim wsparciu przez BIOS komputera, przekroczenie systemowych barier pojemności dysku;

rozszerzenie zakresu identyfikacji dysku przez system.

Wprowadzone przez ATA-2 rozszerzenia podniosły sprawność interfejsu, ale w wyniku ciągłego wzrostu mocy PC i wzrostu objętości użytkowanych danych, konieczne stały się kolejne usprawnienia interfejsu tak, by możliwie niewielkim kosztem dało się uzyskać kolejne zwiększenie sprawności. Zanim to jednak nastąpiło, powstało ATA-3, nie wnoszące żadnych nowych trybów transmisji i przyspieszenia obsługi, a jedynie takie, skądinąd bardzo użyteczne zmiany, jak:

poprawę pewności transmisji danych po kablu, którego możliwości transmisyjne zostały przy uzyskiwanych szybkościach transmisji wyraźnie przekroczone;

wprowadzenie obsługi SMART (Self-Monitoring Analysis and Reporting Technology) techniki zapewniającej znaczne zwiększenie poziomu bezpieczeństwa danych dzięki automatycznej diagnostyce dysku.

Następnym znaczącym krokiem w rozwoju interfejsów z rodziny ATA stał się, stosowany obecnie, nieformalny standard Ultra ATA, umożliwiający transmisję danych multiword w trybie 3 DMA, tzw. DMA-33. Oczywiście taki tryb pracy musi być wspierany od strony jednostki centralnej przez BIOS i logikę płyty głównej. Ze strony logiki dysku konieczna jest dodatkowa kontrola poprawności danych i korekcja błędów transmisji z powodu wspomnianego już przekroczenia przepustowości typowego kabla.

Wszystkie interfejsy ATA charakteryzują się pełną kompatybilnością zstępującą, tzn. każda wyższa wersja obsługuje również pełny zestaw funkcji wersji niższej, dzięki czemu możemy np. dołączyć dysk Ultra ATA do systemu przystosowanego do ATA-2, oczywiście tracąc możliwość wykorzystania zwiększających efektywność funkcji wyższego standardu.

Dopełnieniem rodziny interfejsów IDE/ATA jest ATAPI (ATA Packet Interface), protokół komunikacyjny, umożliwiający komunikowanie się przez interfejs ATA z urządzeniami, nie będącymi dyskami stałymi przede wszystkim z czytnikami CD-ROM. Początkowo protokół ten był obsługiwany przez ładowany do pamięci sterownik, później wbudowany w system operacyjny. Obecnie ATAPI jest wspierany również przez większość implementacji BIOS-u, dzięki czemu możliwe jest np. ładowanie systemu operacyjnego z CD-ROM-u.

Interfejs - ATA:

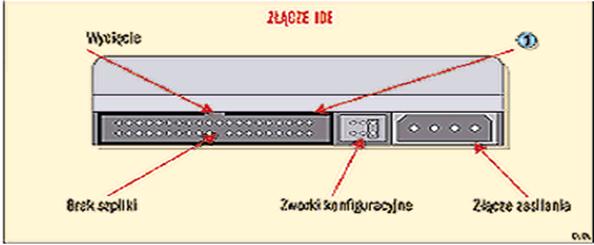

ATA-1 (IDE) ATA (AT Attachment): jest formalną nazwą tego co często jest nazywane oficjalną specyfikacją IDE. Ale IDE (Integrated Drive Electronics) aktualnie oznacza końcówkę interfejsu twardego dysku. ATA to jedno złącze na płycie głównej umożliwające podłączenie maksymalnie dwóch urządzeń master i slave o maksymalnej pojemności 528 MB. Wydajność ATA zależy od trybu transferu danych zwanego PIO (Programed Input/Output). Wszystkie dyski i kontrolery ATA obsługują tryb PIO mode 0 i niektóre obsługują mode 1 i 2. Rodzaj swojego interfejsu można sprawdzić oglądając płytę główną. Płyty z interefsjem ATA mają tylko jedno złącze ATA (nie można podłączyć drugiej taśmy danych oprócz tej do której podpięty jest twardy dysk). Można oczywiście dokupić specjalną kartę ATA-2 mającą dwa kanały ATA i umożliwiającą podłączenie do czterech urządzeń (np. Promise Technology EłDEMax).

ATA-2 (Enchanced IDE/Fast ATA): na płycie z tym interfejsem znajdują się dwa gniazda szpilkowe (zwykle do jednego z nich jest podpięta taśma łącząca płytę z twardym dyskiem i napędem CD-ROM). Innym sposobem na sprawdzenie interfejsu bez rozkręcania komputera prowadzi poprzez menu konfiguracyjne BIOS-u (zwykle po włączeniu komputera należy wcisnąć klaiwsz DEL/ ESC lub CTRL+SHIFT+F1). Wybierz opcję HDD Autodetect. Komputer zacznie rozpoznawać dyski znajdujące się w systemie. Jeżeli na ekranie pokażą się cztery pozycje (nawet puste) to mamy już pewność, że kontroler dysków w kompurterze to ATA-2 lub wyższy. ATA-2 akceptuje dyski większe niż 528 MB lecz mniejsze niż 8.1 GB. Standard ten umożliwia podłączenie maksymalnie dwóch urządzeń (2 x master, 2 x slave) do dwóch kanałów kontrolera (primary i secondary). Zawsze należy podłączać szybkie dyski jako master do kanału primary, natomiest wolniejsze (napędy CD-ROM, stare twarde dyski PIO-2 lub PIO-3) jako master i slave do kanału secondary kontrolera. Taki sposób podłączenia jest szczególnie ważny w systemach 486 i wczesnych systemach Pentium, gdyż kanał EIDE primary ma bezpośrednie połączenie z magistralą PCI, natomiast kanał secondary jest połączony z dużo wolniejszą magistralą ISA.

ATA-3 (Fast ATA): ta wersja ATA akceptuje dyski pracujące w trybie PIO-4 (znanym także jako bezprzerwowym) zapewniającym transfer danych z prędkością 16,7 MB/s.

ATA-4 (Ultra ATA / Ultra DMA / Ultra DMA-33): standard podwaja maksymalny transfer trybu PIO-4 do 33 MB/s. Tryb ten zawiera technologię bus mastering używającego kanału DMA w celu zmniejszenia obciążenia procesora.

Ostatnio najwięksi producenci dysków i komputerów zaanonsowali jeszcze szybszy standard Ultra DMA-66 i 100, według którego dane mogą być przesyłane z prędkością do 66 MB/s.

S.C.S.I. (Small Computer Systems Interface):

Zaawansowany technologicznie typ połączenia komputera z urządzeniami zewnętrznymi takimi jak: streamery, CDROM-y, dyski twarde, skanery itp. Standard SCSI umożliwia połączenie w łańcuch do jednego kontrolera 7, a w przypadku wersji rozszerzonej WIDE SCSI nawet do 16 urządzeń (łącznie z kontrolerem). Dla porównania standard EIDE obsługuje tylko 4 urządzenia dzięki czemu SCSI jest szczególnie przydatny w przypadku dysków twardych, gdyż umożliwia jednoczesne połączenie więcej niż 4 takich urządzeń a każdy z nich może mieć pojemność nawet do 50 GB. SCSI oferuje również szybszy transfer danych między urządzeniami, dochodzący do 80 MB/s (EIDE - 66 MB/s).

Standard SCSI jak i wykorzystujące go urządzenia używane są głównie w komputerach Macintosch oraz szybkich serwerach sieciowych i urządzeniach archiwizujących. Rzadziej w domowych pecetach gdyż urządzenia komunikujące się za pomocą tego standardu są zwykle dwukrotnie droższe od takich samych ale wykorzystujących inne standardy jak EIDE czy USB.

Ogólnie SCSI składa się z 4 części: kontrolera SCSI montowanego zazwyczaj jako karta rozszerzająca (ISA lub PCI), lub gotowego elementu wbudowanego bezpośrednio do płyty głównej, kabla połączeniowego SCSI, samego urządzenia (np. dysku twardego) i tzw. terminatorów w postaci zworek lub dodatkowych złącz, które umieszczane są na dwóch końcach łańcucha połączonych urządzeń SCSI. Dzięki nim kontroler otrzymuje informację gdzie są ostatnie urządzenia łańcucha przez co może sprawnie obsługiwać przepływ danych między poszczególnymi urządzeniami a komputerem.

Standard SCSI od czasu swego powstania uległ kilkakrotnie modyfikacjom przez co możemy mieć doczynienia z kilkoma różnymi wersjami tego samego standardu. Jest to szczególnie kłopotliwe w przypadku dobierania i łączenia ze sobą urządzeń obsługujących różne wersje SCSI. Oto zestawienie najważniejszych standardów SCSI:

SCSI-I Leciwy standard wraz z ujednoliconym nieco później Common Command Set (CIS) pracuje na bazie ośmiobitowej magistrali danych i oferuje maksymalną prędkość przesyłania danych około 3 MB/s. Opcjonalny jest synchroniczny tryb pracy i 5 MB/s.

SCSI-II Oferuje jasno zdefiniowany zestaw poleceń i listę parametrów. Dzięki liście urządzeń uniknięto wiele problemów z napędami CD, MO, wymiennymi dyskami, skanerami itp. Magistrala SCSI-II używa 50 żyłowego kabla SCSI-A i zasadniczo nie jest szybsza niż SCSI-I.

Fast-SCSI Jest przyszłością standardu. Pozwala na transfer danych do 10 MB/s, co osiągnięto m.in. podnosząc częstotliwość taktowania magistrali.

Wide-SCSI To 16-bitowa wersja Fast SCSI, Maksymalnie 20 MB /s może być przesyłane synchronicznie za pośrednictwem 68-żyłowego kabla SCSI-B. Dzięki temu, że do adaptera Wide-SCSI na ogół można podłączyć zarówno SCSI-A, jak i SCSI-B, kontroler ten może jednocześnie obsługiwać urządzenia SCSI-II, Fast SCSI oraz Wide - SCSI.

Ultra-SCSI nazywany również Fast-20-SCSI, stosuje większą prędkość taktowania sygnału przesyłanego zwykłym kablem 50-żyłowym i osiąga wydajność 20 MB/s. Dla urządzeń zewnętrznych wymagany jest specjalny kabel połączeniowy.16-bitowy wariant Ultra-SCSI umożliwia transfer 40 MB/s poprzez kabel SCSI-B nazywany jest Ultra-Wide-SCSI lub Fast-40-SCSI.

Każde z urządzeń SCSI musi mieć przyporządkowany własny adres tzw. ID (od 1 do 15). Dokonuje się tego przełączając odpowiednią zworkę lub pozycję przełącznika (DIP) w urządzeniu SCSI.

Zamieszanie w nazwach:

Gdy oficjalnym standardem został interfejs ATA-2, zaczęły pojawiać się nazwy handlowe w rodzaju Fast ATA czy Enhanced IDE. Miały one znaczenie wyłącznie marketingowe, odnosząc się do sprzętu w jakimś stopniu zgodnego z ATA-2, ale dzięki popularności rynkowej firm używających tych określeń zostały potraktowane i masowo rozumiane jako określenia standardów. Zresztą firmy te, ufne w swoją wielkość i popularność, pozwalały sobie na dość daleko posuniętą elastyczność w stosowaniu się do standardów. Lansowany w swoim czasie przez Quantum interfejs Fast ATA-2 był całkowicie zgodny z ATA-2, nie wyłączając szybkości słowo fast miało charakter wyłącznie marketingowy. Z kolei Fast ATA Seagate to nieco ograniczone ATA-2 (bez obsługi trybów PIO 4 i multiword DMA 2). Ale największego zamieszania narobiło określenie EIDE (Enhanced IDE), stosowane przez Western Digital. EIDE to oprócz wszystkich funkcji ATA-2 także ATAPI i obsługa dwóch kanałów, tj. czterech urządzeń EIDE. Ta ostatnia funkcja co prawda nie ma żadnego odzwierciedlenia w konstrukcji interfejsu i w całości jest obsługiwana przez BIOS i logikę płyty głównej, tym niemniej została ujęta w specyfikacji EIDE. W ten sposób każda współczesna płyta główna jest zgodna z tą częścią specyfikacji Western Digital, nawet jeśli konstruktor płyty nigdy nie słyszał ani o tej firmie, ani o Enhanced IDE.

Kolejnym źródłem zamieszania stał się, obowiązujący obecnie, standard Ultra ATA. Ultra DMA-33, UDMA itp. to kolejne marketingowe nazwy, które wprawdzie niekoniecznie odwołują się do standardu, ale dobrze brzmią. Ostatnim marketingowym sloganem jest DMA-66. A jedyną metodą na połapanie się, z jakim dyskiem naprawdę mamy do czynienia, jest odwołanie się do jego specyfikacji technicznej, w której jasno określone są obsługiwane przez jego interfejs tryby PIO i DMA.

Small Computer System Interface (SCSI) to twór bardziej skomplikowany od stosunkowo prostego interfejsu ATA. Podobnie jak ten ostatni, również i urządzenia SCSI mają wbudowane sterowniki, ale podczas gdy ATA jest praktycznie wyłącznie interfejsem pomiędzy dyskiem a jednostką centralną, SCSI stanowi faktyczną szynę systemową, a inteligentne sterowniki urządzeń i bogaty protokół komunikacji sprawiają, że możliwe jest realizowanie przez SCSI wielu funkcji zupełnie niedostępnych dla urządzeń ATA/IDE, jak choćby wymiana danych pomiędzy urządzeniami SCSI bez pośrednictwa jednostki centralnej. W odróżnieniu od ATA, SCSI zostało zaprojektowane od razu z myślą o szerokiej gamie urządzeń, aczkolwiek w początkowej fazie rozwoju również było dość silnie zorientowane na obsługę dysków.

Bałagan nazewnictwa wewnątrz standardu SCSI ma charakter nieco inny niż w przypadku ATA poszczególne nazwy nie są hasłami marketingowymi, lecz raczej opisową charakterystyką poszczególnych wariantów szerokiej rodziny substandardów, np. Fast Wide SCSI czy Ultra SCSI. Ułatwia to nieco poruszanie się wśród odmian, oczywiście pod warunkiem znajomości ich podstawowych definicji. Na szczęście, mimo nieprecyzyjnego nazewnictwa, poszczególne substandardy są wystarczająco dokładnie zdefiniowane, a ponadto podporządkowane zasadzie kompatybilności zstępującej.

Standard SCSI został zatwierdzony przez ANSI w 1986 roku i bardzo szybko się zestarzał jeśli chodzi o wydajność szyna 8-bitowej szerokości, taktowana zegarem 5 MHz, mogła stanowić dobry system komunikacji 12 lat temu, ale wymagania systemów komputerowych, nawet tych small, wzrastały bardzo szybko. Dlatego już w 1990 roku ANSI zatwierdziło SCSI-2 jako zapis standardu o wariantach dających szeroki zakres możliwości rozwoju.

SCSI w swoich rozlicznych wariantach w stosunkowo niewielkim stopniu znalazł zastosowanie w PC, z dwu głównych przyczyn. Pierwszą z nich była relatywnie wysoka cena urządzeń SCSI i dodatkowy koszt sterownika. Drugą przyczyną ograniczonego stosowania tego interfejsu w komputerach standardu PC był fakt, że zarówno oprogramowanie systemowe (DOS a później Windows), jak i architektura samego komputera nie były przystosowane do wykorzystania możliwości SCSI. Tym niemniej interfejs SCSI bywa stosowany w PC, szczególnie w dwu przypadkach: w maszynach wysokiej klasy, w których koszty nie odgrywają krytycznej roli, natomiast oprogramowanie ma szansę wykorzystania funkcji SCSI, oraz, często w uproszczonej wersji, jako interfejs dla urządzeń takich, jak streamery, skanery, dyski magnetooptyczne i inne urządzenia o dużej objętości danych przesyłanych przez interfejs.

Te najpopularniejsze sterowniki SCSI często mają bardzo ograniczony zakres funkcji zwykle główne ograniczenie polega na tym, że do interfejsu może być podłączone tylko jedno urządzenie nie zaś, jak wynikałoby ze standardu, aż 7. Sterownik taki, zwykle niewspółmiernie tańszy od 'pełnoprawnego', obsługuje podzbiór funkcji SCSI-2 wystarczający do wypełnienia przewidzianej dla niego roli, ale tak naprawdę jest jedynie interfejsem nie obsługuje zarządzania szyną SCSI

EIDE i SCSI podobieństwa i różnice :

Mimo że SCSI powstało nieco wcześniej od swojego konkurenta, jest do chwili obecnej wykorzystywany w dyskach twardych stosowanych w bardziej zaawansowanych systemach komputerowych. Czynnikiem decydującym o wyborze EIDE jest cena. Dyski wykorzystujące ten interfejs są znacznie tańsze, ale czy gorsze? Należy przyjrzeć się bliżej technologii na jakiej bazują obydwa interfejsy.

Technologia:

Od strony fizycznego zapisu danych na nośniku magnetycznym pomiędzy dyskami SCSI a EIDE nie ma praktycznie żadnej różnicy. Niższa cena dysków EIDE wynika z zastosowanych w nich mechanizmów oferujących nieznacznie mniejsze osiągi przy przesyłaniu danych. Kolejnym, bardzo istotnym czynnikiem kształtującym cenę tych dysków jest masowość ich produkcji. Jedną z podstawowych zasad ekonomii jest to, że przy większej produkcji koszty są niższe. Tak jak EIDE postrzegany jest jako podstawowe rozwiązanie dla biurkowych komputerów PC, tak SCSI uważany jest za standard dla serwerów plików, stacji roboczych i systemów biurkowych klasy wyższej. Historia ewolucji IDE i SCSI pokazuje rosnącą popularność obydwu standardów. W klasie wyższej rosną możliwości SCSI, natomiast na rynku masowym EIDE zastępuje wcześniejsze generacje SCSI o podobnych pojemnościach i wydajnościach.

Dyski coraz szybsze:

Wydajność dysku (zarówno SCSI, jak i EIDE) jest określana głównie przez czynniki mające charakter mechaniczny. Są to: czas pozycjonowania mechanizmu głowicy oraz szybkość obrotowa napędu. Pozycjonowanie określa jak szybko głowica odczytująca dane jest w stanie znaleźć się nad właściwą ścieżką, zaś im większa szybkość obrotowa, tym prędzej dany sektor na tejże ścieżce znajdzie się pod głowicą. Niestety, stałe zwiększanie szybkości obrotowej i zmniejszanie czasu pozycjonowania wymaga zastosowania coraz droższych i wytrzymalszych materiałów.

Kiedy S.C.S.I jest wydajniejsze:

W systemach komputerowych posiadających jeden dysk twardy, zakup dysku SCSI jest inwestycją nieco chybioną. Podobna sytuacja zachodzi w przypadku starszych systemów operacyjnych (DOS, wczesne wersje Windows), które nie mają wielozadaniowości. Prawdziwy zysk wydajności wynikający z użycia dysków SCSI będzie widoczny w systemach wielozadaniowych zaopatrzonych w wiele nośników pamięci masowej. EIDE to zasadniczo środowisko jednozadaniowe. Nawet przy zastosowaniu zarządzania magistralą (bus mastering) i funkcjach Ultra DMA, system musi poczekać na wykonanie polecenia przez napęd, tak więc przy posiadaniu wielu dysków EIDE podczas komunikacji komputera z jednym z nich inne czekają dopóki zajęty w danej chwili napęd zakończy swoje zadania. SCSI jest interfejsem inteligentnie zarządzającym zasobami.

Główną jego zaletą jest ustawianie zadań dla dysków w kolejkę. Dysk SCSI po otrzymaniu od systemu zadania odłącza się od interfejsu wykonując przydzielone mu zlecenia, a w tym czasie pozostałe dyski mogą komunikować się z systemem. Ponadto kolejkowanie zadań pozwala na optymalny odczyt danych z każdego dysku. Polega to na tym, że zadania dla każdego dysku są ustawiane nie w kolejności ich otrzymywania, lecz tak, aby droga głowicy danego dysku odczytująca potrzebne w danym momencie dane była jak najkrótsza, co znacznie skraca czas odczytu i oszczędza mechanikę napędu.

Macierz :

Macierz dyskowa, to zestaw zwykle 3 5 dysków widzianych jako jedno urządzenie logiczne, zapewniający redundancję danych wystarczającą do zabezpieczenia ciągłości pracy systemu w wypadku awarii jednego z dysków. Nie jest to może definicja specjalnie ścisła, ale zupełnie wystarczająca w przypadku najczęściej spotykanych macierzy pracujących w systemie RAID3-RAID5 (zbieżność numerów z liczbą dysków jest zupełnie przypadkowa poziomy RAID Redundant Array of Inexpensive Disks odnoszą się do różnych algorytmów zapewniających nadmiarowość danych i związaną z tym odporność na awarie). Gwoli ścisłości, tzw. dyski lustrzane są najprostszą realizacją macierzy w systemie RAID1.

Realizacje macierzy w świecie serwerów PC (w komputerach końcowych są stosowane raczej rzadko) można podzielić na trzy rodzaje: sprzętowe, programowe i autonomiczne. W pierwszym przypadku, wszystkie funkcje sterowania macierzą, kontrolę rozmieszczenia poszczególnych fragmentów danych i obliczanie odpowiednich sum kontrolnych realizowane są przez inteligentny, dedykowany kontroler dyskowy, który również pamięta szczegóły konfiguracji sprzętowej np. przyporządkowanie poszczególnych dysków do macierzy (przykładem są np. macierze Mylexa, dostępne również jako OEM u nawet najbardziej markowych producentów sprzętu komputerowego). W przypadku macierzy programowych, cała inteligencja podsystemu mieści się w driverze właściwym dla danego systemu operacyjnego, podczas gdy sam sterownik może być niemal dowolny (np. zwykłe SCSI-2 Adapteca) w tym systemie macierze realizuje np. Micropolis. Macierze autonomiczne (zwane niekiedy SCSI-TO-SCSI) są realizowane całkowicie zewnętrznie w stosunku do komputera, inteligencja jest wbudowana w specjalny moduł sterujący, natomiast całość jest podłączana do zwykłego kontrolera SCSI i widziana jako pojedynczy dysk logiczny.

n) Szybkość obrotowa

Szybkość obrotowa: dysku twardego to parametr często wykorzystywany przez producentów i dystrybutorów w celach marketingowych. Tymczasem pomyślmy, jakie znaczenie ma on dla użytkownika? Sama szybkość obrotowa dysku jeszcze o niczym nie świadczy. Dopiero w połączeniu z gęstością zapisu możemy mówić o użytkowych walorach tego parametru dysku.

Zasada jest stosunkowo prosta. Jeżeli połączymy największą szybkość obrotową z najwyższą gęstością zapisu, otrzymamy najszybszy dysk a dokładniej: dysk o największym transferze wewnętrznym. O tym, czy dysk taki będzie faktycznie najszybszy w naszym komputerze decydują takie czynniki, jak interfejs pomiędzy dyskiem a płytą oraz przepustowość kontrolera. Warto jednak wiedzieć, że różnice pomiędzy gęstością zapisu dla współczesnych dysków o porównywalnej do siebie pojemności są na tyle małe, że można w pewnym sensie stwierdzić, iż szybkość obrotowa decyduje o szybkości transferu.

Coraz większa pojemność i szybkość obrotowa dysków twardych to jedna strona medalu. Z drugiej mamy przecież do czynienia z konkretnym oprogramowaniem komputera, na którym dany dysk ma pracować. Tutaj trzeba wyraźnie uświadomić sobie możliwe ograniczenia, jakie narzuca używany przez nas system operacyjny czy oprogramowanie BIOS-u komputera.

o) Szybkość przesyłania danych:

Średnia szybkość przesyłania danych: oznacza ilość danych przesyłanych w ciągu sekundy przez twardy dysk. Wartość średnia jest ustalana podczas co najmniej dwóch testów, w jednym z nich odczytywane są wszystkie ścieżki twardego dysku po kolei, a w drugim według przypadkowej kolejności. Szybkość przesyłania danych zależy również od innych charakterystyk dysku, takich jak wewnętrzna szybkość przesyłania danych, szybkość przesyłania danych przez interfejs oraz średni czas dostępu.

Przykład: Do komputera do biura zalecamy twardy dysk o średniej szybkości przesyłania danych wynoszącej 5 MB/s. Twarde dyski w komputerach do zadań domowych oraz multimedialnych powinny umożliwiać przesyłanie danych z prędkością 6 MB/s, jako że będą one zapewne przesyłać więcej obrazów oraz sekwencji wideo. Komputer high-end może osiągać najwyższą wydajność tylko wówczas, jeśli wyposażymy go w superszybki twardy dysk o szybkości przekraczającej 7, a nawet 10 MB/s. Dysk powinien przesyłać dane z szybkością przynajmniej 5 MB/s.

Producenci, zamiast średniej szybkości przesyłania danych, podają często maksymalna szybkość interfejsu, czyli Burst-Rate. Opisy moga brzmieć: Interface Transfer Rate (do dysków firmy Hitachi), Data Transfer Rate to/from Interface (do dysków firmy Maxtor), czy też External Transfer Rate (do dysków firmy Seagate) mają wartości up to 33 MB/s. Aby sugerowana szybkość mogła być przez określony dysk osiągana, musi znajdować się również w jego pamięci podręcznej. Tylko wówczas możemy być pewni, że dysk przesyła dane z szybkością określoną przez producenta. Ze uwagi na to, że powyższy warunek jest rzadko spełniany, miara Burst-Rate jest wartością, która nie powinniśmy się sugerować podczas wybierania optymalnego dla nas twardego dysku.

FAT, HPFS, NTFS

a) FAT:

Jednostką objętości zapisu na dysku jest sektor, mieszczący 512 bajtów danych, a wraz z nimi również dane nadmiarowe zapewniające skuteczną korekcję błędów odczytu. Ale nasze dane rzadko mieszczą się w tak skromnej objętości. Jak zachować ich ciągłość przy podziale na poszczególne sektory? Skąd system operacyjny ma wiedzieć, które sektory wchodzą w skład danego pliku? Każdy z systemów operacyjnych ma własny, specyficzny system opisu danych na dysku, zwany systemem plików. Niektóre, bardziej zaawansowane systemy operacyjne są w stanie posługiwać się równolegle kilkoma systemami plików dyskowych. Najprostszym systemem plików jest, używany przez DOS i Windows, system oparty na tablicy alokacji plików FAT (File Allocation Table). System ten, pierwotnie stworzony na potrzeby zapisu na dyskietkach, dzięki swojej prostocie trafił do obsługi dysków sztywnych w systemach Microsoftu. System FAT początkowo traktował jako jednostkę alokacji danych pojedynczy sektor, w wyniku czego przy 16-bitowej architekturze systemu operacyjnego umożliwiał obsługę dysków o pojemnościach nie przekraczających 32 MB (65536 sektorów).

Obsługę większych pojemności umożliwiło dopiero użycie większych jednostek alokacji, nazywanych klastrami (ang. cluster pęczek, grono). Przy obsłudze woluminów większych od 32 MB wielkość klastra jest zależna od wielkości woluminu i w przypadku np. dysku o pojemności 1 GB klaster liczy sobie 16 kB, a dysk 2,5 gigabajtowy wymaga już klastrów o pojemności 64 kB. Każdy zapisany plik to trochę zmarnowanej przestrzeni, średnio połowa pojemności klastra, bo przecież długość plików jest wielkością przypadkową. W przypadku, gdy dysk służy do przechowywania bazy danych, złożonej z kilku plików po kilkaset megabajtów, nie ma to żadnego znaczenia, ale w przypadku kilku tysięcy plików o różnych długościach, jakie znajdują się na dysku typowego użytkownika, może to być kilkanaście megabajtów straconego miejsca. A w dodatku system odczytuje całe klastry w przypadku potrzeby wczytania liczącego sobie 300 bajtów pliku, np. *.ini, system żąda od dysku odczytu całego klastra. Oprócz straty miejsca jest to również strata czasu!

Dzięki rozmaitym rozszerzeniom i protezom (jak np. VFAT) system FAT dotrwał do chwili, kiedy programiści Microsoftu zdołali stworzyć 32 bitową tablicę alokacji. Zmiana nie tyle jakościowa, co ilościowa dopiero dysk pojemności większej od 2 GB wymaga stosowania jednostek alokacji większych od sektora, a 32-kilobajtowymi klastrami będziemy się posługiwać dopiero w następnym stuleciu.

O wadach systemu FAT, zwłaszcza w jego microsoftowych realizacjach, można by długo pisać. Oprócz wspomnianych już kłopotów, wywołanych przez zbyt małą liczbę dostępnych jednostek alokacji, poważną wadą systemu FAT jest silna fragmentacja plików pomiędzy wiele klastrów o bardzo różnym fizycznym położeniu na dysku. Pociąga to za sobą konieczność okresowej defragmentacji przy użyciu specjalnych narzędzi programowych, a także powoduje stosunkowo duże prawdopodobieństwo powstawania błędów zapisu, polegających na przypisaniu jednego klastra dwóm plikom (tzw. crosslink), co kończy się utratą danych z jednego lub obu skrzyżowanych plików.

Typowym błędem, pojawiającym się w systemie FAT, jest również pozostawianie tzw. zgubionych klastrów, tj. jednostek alokacji nie zawierających informacji, ale opisanych jako zajęte. O tym, jak duże jest prawdopodobieństwo tego rodzaju błędów, świadczy fakt wyposażenia DOS-u od samego początku w narzędzie do ich wykrywania i likwidacji (polecenie CHKDSK).

Na potrzeby OS/2 IBM i Microsoft stworzyły wspólnie system plików HPFS (High Performance File System) stosowany początkowo również jako jeden z systemów plików dla Windows NT. Przeznaczony od samego początku do obsługi dużych dysków system używa dość złożonej struktury zapisu danych. Zapisywanych jest również wiele informacji nadmiarowych, umożliwiających łatwe odtworzenie zapisu w przypadku błędów, a także np. informacje statystyczne o użytkowaniu plików, przeznaczone do wykorzystania przez inteligentny, interaktywny system buforowania operacji dyskowych. System jest również wyposażony w mechanizmy ochrony zapisu przed uszkodzeniem, jak np. automatyczne przenoszenie danych z sektorów o niepewnej jakości do dobrych (tzw. HotFix).

Zaletami tego systemu są przede wszystkim szybkość wyszukiwania danych, wysoki stopień ciągłości ich zapisu, a także bardzo duża niezawodność. Główną wadą zaś stosunkowo długi czas zakładania nowych plików, wynikający z konieczności każdorazowej rekonfiguracji drzewa katalogowego. Niestety, nowe wersje Windows NT (od 4.0) nie obsługują już plików dysków w formacie HPFS pomimo tego, że byłby on wymarzonym rozwiązaniem do obsługi np. dużych, rzadko przebudowywanych baz danych.

Równolegle z udziałem w pracach nad HPFS Microsoft opracował własny zaawansowany system plików NTFS (New Technology File System) przeznaczony dla Windows NT. System ten, oparty na 32-bitowych tablicach FAT, ma dość rozbudowany system bezpieczeństwa, a także mechanizmy ograniczające fragmentację plików. Ciekawą jego cechą jest możliwość przypisania plikom atrybutu kompresji, pozwalającego na ich kompresję w trakcie zapisu.

Jak widać, po wycofaniu się z HPFS, stosowane obecnie najpopularniejsze systemy plików są wciąż oparte na systemie FAT. Wszystko wskazuje na to, że ciągły wzrost pojemności dysków sztywnych, a także wzrastające ilości składowanych danych wymuszą jednak opracowanie i upowszechnienie systemu plików o strukturze bardziej odpowiadającej współczesnej strukturze danych.

b) HPFS (High Performance File System) system plików OS/2:

HPFS został zaprojektowany przez IBM i Microsoft pod koniec lat osiemdziesiątych, dla potrzeb nowoczesnego systemu operacyjnego, realizowanego podówczas wspólnie przez obydwie firmy OS/2. W przeciwieństwie do FAT wymyślonego w 1977 r. do obsługi dyskietek HPFS był od początku przeznaczony od efektywnej obsługi dysków twardych, i to dużych teoretyczna granica wielkości woluminu (nb. ostatnio dodatkowo podniesiona) już wówczas wynosiła 2199 GB, czyli 2^32 sektorów (į 512 B), będących również jednostką alokacji.

Dysk podzielony jest na tzw. pasma po 8 MB (16384 sektory) zawierające bitową mapę zajętości sektorów w paśmie (32 sektory). Dzięki naprzemiennemu ułożeniu map w kolejnych pasmach tworzone są ciągłe odcinki po 16 MB, rozdzielone mapami dwu kolejnych pasm. Jedno pasmo, położone możliwie blisko geometrycznego środka dysku, zarezerwowane jest do przechowywania opisów katalogów, w tym katalogu głównego po jego wypełnieniu katalogi mogą być zakładane również w innych miejscach dysku.

Kluczową dla HPFS strukturą danych jest tzw. Fnode, czyli położony możliwie blisko samego pliku rekord opisujący parametry i położenie pliku (lub katalogu). Jeżeli jest on nie wystarczający do opisu położenia lub tzw. atrybutów rozszerzonych, na dysku tworzone są dodatkowe struktury pomocnicze.

Zawartość katalogów jest posortowana, zapisywana w blokach o wielkości 2 KB, tworzących strukturę tzw. sterty (posortowanego, binarnego drzewa zrównoważonego). Znacznie przyspiesza to wyszukiwanie i dostęp do pliku, ale spowalnia tworzenie, kasowanie i zmianę nazwy wymuszają one reorganizację struktury katalogu. HPFS umożliwia operowanie długimi nazwami (do 256 znaków), kompletem dat (utworzenia, ostatniej modyfikacji i ostatniego dostępu), prawami dostępu oraz tzw. atrybutami rozszerzonymi, mogącymi przechowywać dowolne informacje wykorzystywane przez system plików lub aplikację takie jak np. ikona pliku czy położenie okna na ekranie. Gromadzone są też informacje statystyczne pozwalające na zoptymalizowanie pracy cache'a dyskowego.

W przeciwieństwie do FAT, HPFS definiuje nie tylko ułożenie danych na dysku, ale także sposób korzystania z niego wbudowany cache, mechanizmy minimalizowania fragmentacji itp. Zdefiniowane są też mechanizmy ochrony przed uszkodzeniem: weryfikacja zapisu, hotfix (przenoszenie na gorąco zawartości uszkodzonych sektorów do obszaru rezerwowego), wbudowany CHKDSK, automatyczna kontrola struktury dysku w przypadku wykrycia nieprawidłowego zakończenia pracy systemu.

Specjalne identyfikatory kluczowych wewnętrznych struktur danych oraz dublowanie niektórych informacji w różnych strukturach (np. początkowych fragmentów nazw plików w katalogu i Fnode) umożliwiają natomiast automatyczne odtworzenie struktury dysku nawet w przypadkach ciężkich awarii.

c) NTFS (NT File System) Windows NT:

Ten system plików należy do podstawowych składników bezpieczeństwa Windows NT. Partycja NTFS rozpoczyna się klasycznym sektorem inicjującym. Nie jest to, jakby sugerowała nazwa, pojedynczy sektor, ale może być to nawet 16 pierwszych sektorów (zależnie od potrzeb systemu).

Po sektorze inicjującym występuje tzw. nadrzędna tabela plików (MFT Master File Table), czyli po prostu indeks plików systemowych (ich nazwy zaczynają się od znaku '$'). W aktualnej wersji systemu NT na pliki systemowe wymienione w MFT składają się:

kopia MFT;

plik logów;

informacje o wolumenie (w tym etykieta wolumenu i numer wersji NTFS);

tablica definicji atrybutów (nazwy, numery identyfikacyjne, objaśnienia);

katalog główny;

mapa bitowa klastrów (opis zajętości partycji);

kopia boot sektora partycji;

tabela uszkodzonych klastrów;

tabela konwersji małych liter na duże odpowiedniki Unicode.

Poza tym tabela MFT zawiera 6 wolnych pozycji (zapisów), które mogą zostać wykorzystane w przyszłości. Jak można wywnioskować na podstawie budowy MFT system NTFS podobnie jak FAT opiera się na klastrach. Jednak rozmiar klastra ustalamy tutaj dość swobodnie od 0,5 KB do 64 KB.

W podanym przy FAT przykładzie (partycja 2 GB) domyślny rozmiar klastra wynosi 4 KB czyli 8 razy mniej niż w poprzednim przypadku FAT.

Oprócz zaawansowanego, elastycznego systemu bezpieczeństwa jedną z bardziej interesujących cech NTFS jest mechanizm kompresji w locie. Jednak w odróżnieniu od rozwiązań typu DriveSpace (dla VFAT) możemy kompresować nie tylko całe wolumeny, ale nawet w standardowo niekompresowanym wolumenie pojedyncze pliki lub katalogi.

To, czy dany element ma być kompresowany ustala się za pomocą klasycznego ustalania atrybutów (w ten sam sposób jak ustala się atrybut tylko do odczytu czy też ukryty). Jedynym ograniczeniem kompresji NTFS jest to, że rozmiar klastra nie może być większy niż 4 KB.

d) Oznaczenia producentów:

Zawierają wiele informacji dotyczących twardego dysku. Po dokładnym przemyśleniu wszystkich za i przeciw zdecydowaliśmy się na zakup określonego modelu dysku może być tak, że modele oferowane przez sprzedawcę nie mają nazw typu Fireball, Cheetah, czy Hornet, lecz nazwy kodowane. Oto przykłady, w jaki sposób należy je odczytywać:

Seagate przyklad: ST340810A

ST określa producenta dysku, czyli firmę Seagate.

Pierwsza cyfra określa wysokość dysku i jego format: 1 określa dysk o wysokości 41mm (3,5 cala), 3 25 mm (3,5 cala), 4 82 mm (5,25 cala), 5 19 mm (3,5 cala) i 9 na określenie dysków 2,5-calowych o różnych grubościach.

Kolejne cyfry informują o pojemności dysku mierzoną w MB.

Jedna lub dwie litery na końcu nazwy określają interfejs: A oznacza AT-Bus (EIDE), N oznacza SCSI, W Wide SCSI, a FC Fiber Channel.

Fujitsu przykład: MPB3021

Pierwszy znak alfanumeryczny określa rodzaj głowicy odczytująco zapisującej: M oznacza głowice MR (ang. Magnetoresistive) GM oznacza głowice GMR (ang. giant magnetoresistive).

Litera druga oznacza rodzaj dysku: A Allegro (czyli dysk SCSI), H Hornet (czyli 2,5 calowy dysk do notebooków), P Picobird (czyli dysk EIDE Ultra-DMA/33).

Ostatnia z liter określa generacje twardego dysku. Modele nowsze wyprodukowane po październiku 1998 oznaczone są litera C.

Pierwsza cyfra określa format dysku, gdzie 2 oznacza dysk 2,5 calowy, a 3 dysk 3,5 calowy.

Następne trzy cyfry tworzą liczbę, która po podzieleniu przez 10 wskazuje na pojemność dysku mierzona w GB.

Hitachi przykład: DK238A-32

Pierwsze dwa znaki (DK) oznaczają dysk. Pierwsza cyfra określa format dysku, gdzie 2 oznacza dysk 2,5-calowy (który Hitachi produkuje wyłącznie z interfejsem EIDE), a 3 dysk 3,5-calowy (z interfejsem SCSI).

Druga cyfra oznacza wysokość dysku (dla dysków 2,5 calowych cyfry 1, 2 i 3 oznaczają odpowiednio: 19,0; 12,7 i 9,5 milimetra; a dla dysków 3,5 calowych 1 oznacza 41mm, a 2 25 mm wysokości.)

Trzecia cyfra określa generacje twardego dysku (obecnie aktualnymi są generacje 7 i 8).

Litera poprzedzająca myślnik jest oznaczeniem wewnętrznym Hitachi.

Liczba po myślniku podaje pojemność dysku w przypadku dysków o pojemności mniejszej niż 10 GB liczbę ta należy podzielić przez 10.

IBM przykład: DCAS-34330