| CATEGORII DOCUMENTE |

Universitatea "Politehnica" din Timisoara

Facultatea de Electronica si Telecomunicatii

OPTIMIZAREA PAGINILOR DE INTERNET PENTRU MOTOARELE DE CAUTARE

Capitolul I Motoare de Cautare

I.1. Evolutia in timp a motoarelor de cautare.

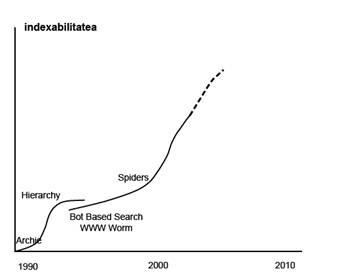

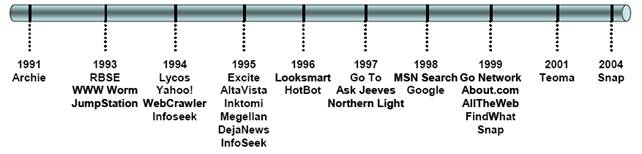

In primele zile ale internetului utilizatorii isi partajau fisierele intre ei folosind servere FTP. Pentru a facilita gasirea acestor fisiere a aparut Archie, care punea la dispozitie prima colectare de date bazata pe utilizarea unui script care avea totodata si capacitatea de interogare. Bazate pe succesul lui Archie au fost create si alte motoare de cautare cel mai popular fiind Gopher. Pe langa Gopher, Veronica si Jughead au fost alte doua instrumente de cautare scrise in 1993. Acestea reprezinta prima curba S in evolutia cautarii pe internet.

Problema cu aceste instrumente a

fost ca utilizatorul trebuia sa mentina manual directorul

de site-uri care ar fi putut cautate.

Problema cu aceste instrumente a

fost ca utilizatorul trebuia sa mentina manual directorul

de site-uri care ar fi putut cautate.

Acest lucru a dus insa la limitarea lui in acoperire" si a devenit repede depasit. Aproximativ in acelasi timp, Matthew Gray de la MIT a scris World Wide Web Wanderer, care devenea primul robot. Robotii au fost o inovatie a starii de cautare existente, tehnologie care permitea in mod automat calculatoarelor sa indexeze si sa reindexeze situri. In timp ce numarul de situri indexate a crescut semnificativ datorita automatizarii acestui proces, relevanta rezultatelor returnate a devenit problema principala. Cu toate acestea o perioada de timp producatorii de motoare de cautare s-au concentrat pe creearea unur roboti cat mai eficienti. ,,Paianjenii" au fost o alta inovatie semnificativa si au venit ca o imbunatatire adusa robotilor - ei nu numai ca au indexat continutul paginilor, ci au si urmat link-urile din pagina pentru a gasi noi situri.

Astfel trei noi motoare de cautare care au aparut au imbratisat aceasta tehnologie: JumpStation, the World Wide Web Worm si Repository-Based Software Engineering (RBSE) Spider. Robotii si ,,paianjenii" reprezinta cea de-a doua curba S in evolutia motoarelor de cautare.

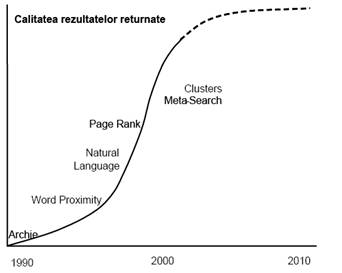

JumpStation si WWW Worm pur si simplu afisau rezultatele enumerandu-le in ordinea in care le-au gasit pe web. Acest algoritm de tip FIFO (First In First Out - Primul Intrat Primul Iesit) nu a fost scalabil, curand aceste doua motoare disparand. Cu toate ca RBSE a implementat un sistem de ranking (de notare), desi nu de succes, a fost un factor care a contribuit semnificativ la imbunatatirea relevantei rezultatelor afisate.

Concentrarea asupra afisarii unor rezultate de calitate din multe proiecte universitare a condus la lansarea unor noi companii de motore de cautare. Proiectul Architect din cadrul universitatii Stanford recurgea la analiza statistica a legaturilor dintre cuvinte pentru a imbunatati cautarea. Un grup de sase elevi absolventi au promovat aceasta tehnologie intr-un proiect pilot numit Excite. La inceputul anului 1994, David Filo si Jerry Yang doi doctoranzi de la Stanford au inceput sa creeze un director cu siturile lor preferate. Pe masura ce numarul lor a crescut , au adaugat capacitatea de cautare acestui director si astfel a luat nastere Yahoo!. Curand dupa aceea, Brian Pinkerton de la Universitatea din Washington, a lansat WebCrawler3 care utiliza primul robot care indexa intregul continut al unei pagini web. Tot acelasi an, Lycos a fost infiintat. Michael Mauldin a fost creditat cu prima utilizare a proximitatii cuvintelor in relevanta rezultatelor de cautare. Infoseek de asemenea, a fost fondat in 1994. Alta metoda inovativa au constituit-o interogarile in limbaj natural de la AltaVista din anul 1995. Pana in acest punct robotii pur si simplu urmau link-urile de la o pagina la alta ceea ce facea ca noile situri web sa obtina vizibilitate foarte greu.

AltaVista a inceput sa permita clientilor

sa-si introduca singuri link-uri, cupland acest fapt cu o

latime de banda foarte mare a impins AltaVista in frunte. In 1996 ia

nastere Inktomi fiind fondat de doi studenti de la Berkeley. Looksmart a

fost lansat, de asemenea, in 1996, si a devenit motorul de cautare

implicit pentru MSN pana in 2004. Acesta a fost urmat de Ask Jeeves si de Northern Light in 1997. In 1998, Google

a fost fondat de Larry Page si Sergey Brin, studenti absolventi in

stiinta calculatoarelor la Universitatea Stanford. Goolge,

initial numit BackRub4 a dat prioritate in rezultatele afisate

siturilor care au fost cel mai frecvent referentiate sau care au avut

referite de la situri importante. Datorita intoarcerii unor rezultate

mult mai semnificative comparativ cu alte motoare de cautare Google a

devenit rapid motorul de cautare numarul unu.

AltaVista a inceput sa permita clientilor

sa-si introduca singuri link-uri, cupland acest fapt cu o

latime de banda foarte mare a impins AltaVista in frunte. In 1996 ia

nastere Inktomi fiind fondat de doi studenti de la Berkeley. Looksmart a

fost lansat, de asemenea, in 1996, si a devenit motorul de cautare

implicit pentru MSN pana in 2004. Acesta a fost urmat de Ask Jeeves si de Northern Light in 1997. In 1998, Google

a fost fondat de Larry Page si Sergey Brin, studenti absolventi in

stiinta calculatoarelor la Universitatea Stanford. Goolge,

initial numit BackRub4 a dat prioritate in rezultatele afisate

siturilor care au fost cel mai frecvent referentiate sau care au avut

referite de la situri importante. Datorita intoarcerii unor rezultate

mult mai semnificative comparativ cu alte motoare de cautare Google a

devenit rapid motorul de cautare numarul unu.

Evolutia Motoarelor de Cautare

I.2. Motorul de cautare: definitie si structura.

Luat ca atare, motorul de cautare este solutia viabila prin care, din masa imensa si relativ dezorganizata de documente de pe Web, o anumita cantitate este pusa la dispozitia utilizatorului conform nevoilor sale particulare. El permite efectuarea unei cautari pe baza unor criterii de cautare si obtinerea unor rezultate care corespund criteriilor. Practic, motorul de cautare preia atributiile unui seviciu de 'cautare' si 'livrare' a informatiei, revolutionand felul in care oamenii lucreaza cu informatia, o stocheaza, o folosesc, o popularizeaza.

Avantajele acestei practici de informare sunt multiple. Pe de o parte caracterul global al informatiilor - cautarile si implicit rezultatele, depasesc nu doar granitele teritoriale ci si pe cele temporale, motoarele de cautare avand capacitatea de a opera cu texte cu o rata de modificare crescuta, fara a afisa rezultate lezate in actualitatea lor, iar pe de alta parte, de relevanta informatiei, dublata de viteza de numai cateva secunde necesara obtinerii ei.

Motorul de cautare este din punct de vedere al interfetei un camp in care utilizatorul poate introduce termenul sau propozitia dupa care doreste sa caute. In momentul in care este apasat butonul cauta un algoritm examineaza baza de date din spatele motorului de cautare si returneaza rezultatele pe care le considera relevante pentru termenul/termenii introdusi. In spatele acestei interfete simpliste se gaseste de fapt un software complet care utilizeaza mai multe aplicatii pentru a colecta informatii despre paginile web. Informatiile colectate sunt: cuvinte cheie sau propozitii care sunt considerate relevante pentru pagina respectiva, URL-ul paginii respective precum si numarul de link-uri interne si externe. Aceste informatii duc la indexarea paginii de internet si la memorarea intr-o baza de date.

Strucura unui motor de cautare

a) interfata de interogare - reprezinta partea cu care sunt familiarizati cei mai multi utilizatori de internet. Aceasta nu difera foarte mult de la un motor de cautare la altul insa in zilele noastre acestea au devenit extrem de customizabile. Iata doua exemple din cele mai familiare: Google si Yahoo!.

b) spiders sau in traducere libera paianjenii - sunt programe construite de proprietarii motoarelor de cautare care scaneaza websiturile care au rolul de a strange informatii despre toate websiturile existente in internet, informatii care sunt stocate intr-o baza de date si asociate URL-ului corespunzator. Spiderii mai sunt cunoscuti si sub denumirea de crawlers sau robots.

c) baza de date - orice motor de cautare contine sau este conectat la o baza de date unde informatiile despre ficare URL din internet sunt stocate. Fiecare baza de date contine o serie variata de informatii despre paginile web precum si pozitia de afisare a acestora in functie de algoritmul de cautare utilizat de motorul respectiv

d) algoritmul de cautare - este "creierul" oricarui motor de cautare, care face ca totul sa functioneze. Calitatea unui algoritm de cautare este data de relevanta rezultatelor returnate de motorul de cautare. Algoritumul de cautare realizeaza o interogare complexa a bazei de date din spatele motorului de cautare si returneaza rezultatele obtinute. Motoarele de cautare se diferntiaza intre ele tocmai prin algoritmul utilizat de fiecare. Performanta motoarelor de cautare vizavi de relevanta informatiei afisate, este rezultatul unui algoritm propriu de indexare si cotare a paginilor web. Majoritatea acestor motoare de cautare, ascund in spate o divizie intreaga de calculatoare a caror atributie principala este de a indexa cuvinte din fiecare document si de e stoca informatia intr-un format optim. Patternul (modelul) de stocare este in general arborescent, astfel ca in momentul in care un utilizator formuleaza o solicitare prin anumite cuvinte cheie rezultatul ia in calcul intreg arborele acelei expresii sau cuvant cheie eliminand gradual ceea ce nu corespunde criteriilor. Cu toate acestea procesul nu este in totalitate congruent. Datorita faptului ca 95% din textul de pe Web este compus din aproximativ 10000 de cuvinte, multe din paginile ce includ cuvintele respective figureaza la modul cel mai firesc in categoria paginilor semnificative cauzand un volumul extrem de mare de rezultate. Selectionarea paginilor in functie de gradul de relevanta, a impus creerea unei modalitati de clasare a lor, proportionala cu importanta, fara a neglija criteriile de baza ale cautarii, si in final plasarea celor mai importante pagini in capul listei rezultatelor. Pentru a limita major coeficientul de eroare asociat acestei proceduri, responsabilitatile clasificarii au fost derogate instumentelor de evaluare automata bazate pe calculul algoritmic.

Algoritmii de cautare se clasifica astfel:

Algoritmi de cautare in lista - un astfel de algoritm cauta intr-un set de date dupa o singura cheie. Informatia este cautata utilizand o metoda liniara. Rezultatul unei astfel de cautari este de obicei unul singur insa cautarea se face foarte greoi datorita numarului extrem de mare de pagini web.

Algoritmi de cautare arborescenta - rezultatele unei astfel de cautari sunt returnate in urma parcurgerii structurii arborescente de date de la radacina la varf sau invers.

Algoritmi de cautare de tip SQL - acest tip de algoritm permite realizarea unei cautari intr-o maniera neierarhica.

Algoritmi de cautare "in cunostiinta de cauza" - in ciuda numelui acest tip de cautare nu este unul dintre cele mai bune datorita rezultatelor mult prea generale pe care le returneaza. Acest tip de algoritm cauta un raspuns specific la o problema specifica intr-o structura de date arborescenta.

Algoritmi de cautare cu constrangeri - acest tip de algoritm ofera unele din cele mai bune rezultate de cautare in internet. Cautarea se poate realiza prin diferite metode care nu trebuie neaparat sa fie liniare. Una dintre aceste metode este clustering-ul. Clustering-ul este o tehnica de invatare nesupervizata care determina o structura intrinseca intr-o multime de date. Aceasta metoda este un proces de organizare a obiectelor care sunt asemanatoare dintr-un anumit punct de vedere.

Acestea sunt doar cateva din metodele utilizate de motoarele de cautare pentru afisarea rezultatelor principalii algoritmi folositi fiind strict secreti.

e) afisarea rezultatelor si pozitia paginii in lista de rezultate - afisarea paginilor in urma unei cautari este rezultatul combinat al activitatii spider-ilor, bazei de date si al algoritmului de cautare. Toate aceste trei componente lucreaza impreuna pentru a returna rezultate cat mai relevante pentru propozitia sau cuvintele dupa care s-a efectuat cautarea.

I.3. Clasificarea motoarelor de cautare.

Motoarele de cautare pot fi impartite in trei categorii diferite: motoare de cautare principale, motoare de cautare secundare si motare de cautare de nisa sau targhetate.

Motoare de cautare principale

Din aceasta categorie fac parte: Google, Yahoo! si MSN, numite si motoare de cautare majore. Acestea sunt motoarele de cautare cu cei mai multi utilizatori si sunt principalul target al celor care se ocupa cu SEO.

Motoare de cautare secundare

Acestea au un numar de utilizatori mai restrans si cu siguranta nu vor aduce foarte mult trafic sitului dumneavoastra web, cu toate acestea nu trebuie ignorate atunci cand se realizeaza optimizarea sitului. Din aceasta categorie fac parte LookSmart, Miva, Ask si Espotting. Majoritatea componentilor acestei categorii sunt metamotoare de cautare sau motoare al caror principal criteriu de indexare al paginilor web il constituie cautarea in continutul tag-urilor meta.

Motoare de cautare de nisa

In cazul acestor tipuri de motoare de cautare rezultatele returnate sunt mult mai specifice. Ele se focuseaza pe un domeniu mult mai restrans cum ar fi: calatoriile, medicina, sportul etc. Dintre motoarele de acest gen putem mentiona urmatoarele: CitySearch, Yahoo! Travel si MusicSearch.

I.4. Scurta descriere a principalelor motoare de cautare.

Cercetarile pozitioneaza Google drept lider in randul motoarelor de cautare, cu un procent de 45% din totalul cautarilor. Succesul este datorat in mare parte conceptului Google cu privire la popularitatea linkurilor si PageRank-ului. Numarul de websituri si pagini webi conexe unei anumite pagini este cuantificat de catre PageRank, pornind de la premiza ca paginile dorite si de calitate, sunt legate intre ele mai mult decat celelalte.

PageRank -ul paginilor conexe si numarul de linkuri de pe aceste pagini contribuie la stabilirea PageRank-ului paginilor. Google isi ordoneaza rezultatele dupa criteriul numeric al multimii websiturilor ce se inlantuiesc la fiecare pagina gasita. Algoritmul "tinerii minte" a locului unde sunt plasate si indexate cross - linkurile si gruparea lor pe categorii este extrem de importanta pe termen lung. PageRank-ul are la baza "analiza pe criterii" dezvoltata in 1950 de Eugene Garfield de la Universitatea din Pennsylvania.

Pe langa cautarile standard pe Internet, Google pune la dispozitia utilizatorilor cautarile specializate precum cele de imagine, video sau blog. Motorul de cautare WATCH, recomanada Google in special pentru cautarile de stiri. Putem cauta produse online pe Froogle, sau rasfoi carti cu ajutorul Google Books. Prin cautarea locala gasim bussiness-urile din orice domeniu impreuna cu o harta sau chiar o imagine din satelit. Accesand Google Lab puteti incerca versiuni beta sau chiar mai noi ale instrumentelor de cautare.

2. Yahoo! Search Engine (https://www.yahoo.com)

Surpinzator am putea spune, motorul de cautare Yahoo! se bucura de o popularitate mai mare decat MSN Search sau Windows Live, clasandu-se in multe din studiile comparative pe locul doi, nu doar pentru relevanta rezultatelor ci si pentru usurinta in folosire. Desi utilizatorii prefera Google in partea de relevanta, le place Yahoo mai ales cand vine vorba de cautari de imagini sau cautari locale. Coceptul ce a stat la baza dezvoltarii Yahoo! apartine fondatorilor, David Filo si Jerry Yang, de la Universitatea Stanford. Cei doi si-au inceput cercetarea intr-o rulota in campusul universitatii in februarie 1994 cu scopul de a tine evidenta problemelor de interes personal de pe Internet, ajungand sa aloce mai mult timp listei lor de situri favorite decat lucrarii de dizertatie de la doctorat. Lista devenind prea lunga si prea vasta ei s-au vazut nevoiti sa o imparta pe categorii. Cand aceste categorii au devenit neincapatoare au dezvoltat subcategorii si asa s-a nascut ideea fundamentala pentru Yahoo!. In 2002, Yahoo! a cumparat Inktomi si in 2003, Yahoo! a cumparat Overture, care detinea AlltheWeb si AltaVista. Cu toate ca dispunea de propriul motor de cautare, Yahoo! a continuat sa folosesca Google pentru a le oferi utilozatorilor rezultate pe pagina principala Yahoo.com. Totusi, in 2004, Yahoo! a lansat propriul motor de cautare combinand tehnologiile achizitiilor anterioare, oferind un serviciu care aloca intaietate motorului de cautare asupra directorului.

Detinut de Microsoft, MSN Search Engine ocupa paradoxal ultima pozitie potrivit testelor Keynote Studies din cauza caracteristicilor de utilizare greoaie, dar iese pe prima pozitie, in fata Google pentru relevanta informatiei. Cu versiunea beta, Windows Live Search, rapoartele afirma ca "s-a produs o mare imbunatatire pentru MSN Search - sub aspectul flexibilitatii si facilitatii in utilizare". Windows Live Search afiseaza rezultatele pe o singura pagina, ne mai fiind nevoie de vreun clik pentru a trece mai departe. Tototdata Windows Live Search detine intaietate pe partea de personalizare a cautarilor. Rezulatele pot fi salvate si impartasite celorlalti ba chiar mai mult de atat Windows Live Search va da posibilitatea sa va creati modelul propriu de motor de cautare. O versiune beta a unui motor de cautare mobil este in curs de dezvoltare pentru PDA, Smartphones si celurare.

Ask.com sau initial Ask Jeeves, a fost primul motor de cautare "intrebare - raspuns" comercial pentru World Wide Web. Este detinut de IAC. In 2006, a devenit al patrulea motor de cautare ca marime din lume. Ask.com are un oarecare avantaj datorita faptului ca rezultatele de top sunt de obicei din surse web extrem de cotate. Rezultatele includ o serie de cross-linkuri pentru rafinarea cautarilor.

Din punct de vedere al utilizarii motoarelor de cautare un studiu realizat la nivel global citat de BBC arata ca in luna august a anului 2007 au fost realizate peste 61 de miliarde de cautari pe internet de catre mai bine de 750 de milioane de utilizatori. Studiul claseaza Google pe primul loc cu mai bine de jumatate din numarul de cautari (37 de miliarde), fiind urmat la distanta de Yahoo (8,5 miliarde) si motorul de cautare chinez, Baidu (3,2 miliarde). Motorul companiei Microsoft se situeaza pe locul patru in acest clasament cu 2,1 miliarde de cautari. "Includerea motoarelor de cautare asiatice in clasament subliniaza faptul ca internetul si cautarile pe internet au devenit un fenomen cu adevarat global", a declarat vicepresedintele executiv pentru pietele internationale al comScore, companie care a realizat studiul.

In privinta distribuirii geografice, studiul arata ca cea mai mare parte a activitatilor de cautare a avut loc in regiunea Asia-Pacific si mai exact in tarile: China, Japonia si India, cu un numar de 258 de milioane de utilizatori care au efectuat 20,3 miliarde de cautari in luna august. Europa se afla pe locul doi ca numar de utilizatori care efectueaza cautari pe internet cu 210 milioane, urmata de America de Nord cu 206 milioane. "Piata cea mai putin dezvoltata de cautari pe internet este cea din Africa Centrala si de Est, cu aproximativ 30 de milioane de utilizatori care efectueaza cautari pe internet", specifica raportul.

Capitolul II Tehnici de optimizare a paginilor web

II.1. Ce este si ce presupune SEO.

SEO este acronimul pentru Search Engine Optimization provine din limba engleza si se traduce prin optimizarea paginilor web pentru motoarele de cautare. In zilele noastre SEO este un termen destul de vast iar studiul acestuia presupune analiza mai multor aspecte pornind de la intelegerea modalitatii de functionare a motoareleor de cautare pana la proiectarea corecta a paginilor web. Exista foarte multe elemente de care trebuie tinut cont incat optimizarea paginilor web poate deveni coplesitoare si totodata consumatoare de timp, insa cu un plan bun aceasta poate fi relizata, atata timp cat conceptul de optimizare o fost bine inteles.

Optimizarea paginilor de internet pentru motoare de cautare este de fapt o "colectie" de strategii care aplicate imbunatatesc pozitia paginii dumneavoastra in lista de rezultate returnata de motoarele de cautare, pentru o anumita fraza sau anumite cuvinte cheie.

La inceputurile internetului, motoarele de cautare afisau in urma unei cautari, pagini in a caror descriere se afla cuvantul de cautare. Deoarece webmaster-ii (proprietarii de site-uri) au facut abuz de acest factor, motoarele de cautare au alcatuit algoritmi mult mai complecsi, care includ:

Textul din Tag-ul title

Numele de domeniu

Elementele HTML (Tag-urile HTML)

Frecventa unui cuvant cheie, atat in pagina cat si global

Sinonime ale cuvantului cheie

Atributele ALT pentru imagini

Titlul link-urilor

Numarul total de hyperlink-uri de la si spre o pagina

Calitatea site-urilor de la care pleaca link-uri spre o pagina

Varsta unui site

In sens larg , SEO este intr-o oarecare masura si marketing prin intelegerea modului in care functioneaza algoritmii de cautare, si ce ar cauta vizitatorii, pentru a stabili corespondenta cu siturile oferind ce acestia cauta. Anumite eforturi SEO pot implica optimizarea codarii unui site, fara a face modificari vizibile pentru vizitatori, precum ierarhizarea structurii sitului, evitarea sau rezolvarea unor probleme care ar putea impiedica motoarele de cautare sa indexeze complet situl. Alte eforturi mai vizibile ar fi includerea de continut unic care este usor indexat si extras de pe situri web datorita vizitatorilor umani.

Optimizatorii pentru motoarele de cautare, adesea ofera SEO ca un serviciu singular, facand parte dintr-o campanie mai mare de marketing. Deoarece un proces de optimizare eficient poate cere schimbari in codul sursa al sitului, este recomandat sa fie inclus in dezvoltarea initiala si designul sitului, ajungand la folosirea termenului "Search Engine Friendly" ("Prietenos Motoarelor de Cautare") pentu a descrie designul, meniurile, sistemul de management al continutului, si al cosului de produse, daca este cazul, care poate fi optimizat usor si eficient.

Se spune ca Google are peste 300 de factori in componenta algoritmului de afisare a rezultatelor, ceea ce a creat numeroase polemici legate de tacticile folosite pentru SEO, in randul webmaster-ilor.

SEO presupune o analiza corecta a cuvintelor cheie dupa care se vrea facuta optimizarea, alegerea inspirata a domeniului, utilizarea corecta a tagurilor, realizarea unei navigari in sit facila si totodata intuitiva, punerea la dispozitia vizitatorilor a unui continut bine structurat si atractiv din punct de vedere al informatiilor oferite precum si alte aspecte ce vor fi detaliate in cele ce urmeaza.

II.2. Cuvintele cheie, alegerea corecta a acestora si importanta densitatii lor in relevanta rezultatelor returnate.

Practic, cuvintele cheie evidentiaza esenta sitului dumneavoastra. Cuvintele cheie reprezinta acele cuvinte pe care un potential vizitator al sitului dumneavoastra, le-ar tasta in campul de interogare al motorului de cautare pentru a gasi situri web conexe la o anumita tema. Tot procesul de optimizare se va realiza in jurul acestor cuvinte cheie. Utilizarea corecta a cuvintelor cheie in continutul sitului poate face diferenta intre o pozitie in primele douazeci de site-uri web afisate de motorul de cautare (lucru care este optim) si o pozitie mult prea in spate pentru a putea fi remarcat, ceea ce inseamna ca cel putin cateva sute de rezultatele au fost returnate inaintea sitului dumneavoastra. Studiile arata ca cei care cauta informatii pe internet rareori trec mai incolo de primele doua pagini de rezultate ce sunt afisate in urma unei cautari.

Pozitia in lista de rezultate a motoarelor de cautare este puternic influentata de ce cuvinte cheie alegeti pentru situl dumneavoastra precum si de modul si locul in care acestea sunt plasate in continutul sitului. Utilizate corect aceste cuvinte vor permite plasarea paginii dumneavoastra in primele doua pagini de rezultate ale principalelor motoare de cautare ceea ce va creste enorm numarul de vizitatori tinand cont de faptul ca majoritatea utilizatorilor internetului folosec motarele de cautare pentru gasirea informatiilor care ii intereseaza.

Alegerea corecta a cuvintelor cheie presupune o analiza coerenta a segmentului de utilizatori pe care situl dumneavoastra il targheteaza. Exista mai multe moduri de a gasi cuvinte cheie potrivite pentru siturile web pe care le dezvoltati. Unele idei bune de cuvinte cheie sunt:

Cuvintele dupa care oamenii ar cauta pentru a gasi produsul sau serviciul pe care il oferiti.

Problemele pe care eventualii dumneavoastra clienti ar putea sa le rezolve cu ajutorul produselor sau serviciilor pe care le promovati, sau cu ajutorul informatiilor pe care situl dumneavoastra le pune la dispozitie.

O alta miscare inteligenta ar fi utilizarea unor unelte care sa va sugereze anumite cuvinte cheie

Scopul cuvintelor cheie este de a alege acei termeni care vor aduce pe situl dumneavoastra trafic bine targhetat. Fiecare pagina din sit poate fi optimizata pentru diferite cuvinte. Trebuie insa mentionat ca optimizarea unei pagini nu se poate realiza pentru un numar mare de cuvinte diferite.

Exista o serie de unelte ce pot fi utilizate pentru o alegere "inspirata" a cuvintelor dupa care trebuie facuta optimizarea, unelte pe care le voi prezenta in continuare:

Google - Suggest. Acesta a fost lansat de Google la sfarsitul anului 2004 si incearca sa completeze cuvintele dupa care se cauta pe masura ce tastati. Rezultatele sunt influentate de popularitatea anumitor grupuri de cuvinte dupa care s-au realizat cautari pe google.

WordTracker. Este o unealta cu ajutorul careia se poate realiza o analiza mai complexa in ceea ce priveste cuvintele cheie insa aceasta este contra cost.

GoodKeyords. Este un software care poate fi decarcat gratuit de pe internet si care poate furniza o serie de informatii utile insa doar pentru cuvinte cheie in limba engelza.

Densitatea cuvintelor cheie si influenta acesteia asupra rezultatelor returnate de motarele de cautare este un subiect destul de controversat. Voi prezenta in cele ce urmeaza pareri pro si contra legate de importanta valorii densitatii cuvintelor cheie.

In literatura de specialitate densitatea cuvintelor cheie notata in cele ce urmeaza cu KD este definita astfel:

Ecuatia 1: ![]() ,

,

unde ![]() repreinta

numarul de aparitii ale termenului i in documentul j iar l este numarul total de cuvinte din

document. Conform teoriei Dr. Edel Garcia densitatea cuvintelor cheie nu are nici

un rol in realizarea unei mai bune indexari a paginilor web, majoritatea

optimizatorilor utilizand aceasta metoda din cauza dezinformarii.

repreinta

numarul de aparitii ale termenului i in documentul j iar l este numarul total de cuvinte din

document. Conform teoriei Dr. Edel Garcia densitatea cuvintelor cheie nu are nici

un rol in realizarea unei mai bune indexari a paginilor web, majoritatea

optimizatorilor utilizand aceasta metoda din cauza dezinformarii.

Daca doua documente, D1 si D2 contin 1000 de termeni (I=1000) si un termen se repeta de 20 de ori (tf=20), atunci pentru ambele documente KD=20/1000=0.020 (sau 2%) pentru termenul respectiv. Valori identice se obtin daca tf=10 si I=500. Evindent, acest raport total nu ne spune nimic despre:

distanta relativa dintre cuvintele cheie din documente (proximitate)

unde apare termenul intr-un document (distributie)

co-citatia frecventei dintre termeni (co-aparitie)

tema principala, subiectul sau sub-subiectele (probleme la subiect) ale documentelor

Cu toate acestea, KD este separat de calitatea continutului, semantica si relevanta.

in aceste conditii cu greu se poate vorbi despre optimizarea ponderilor termenilor cu scopul de a ierarhiza. Urmatoarele cinci implementari ale motoarelor de cautare ilustreaza acest punct de vedere

Liniarizarea

Tokenizarea (presupune inlaturarea semnelor de punctuatie din textul sitului web)

Filtrarea

Stemming (Stemming este procesul de aducere a cuvintelor la forma cea mai simpla pentru a eficientiza cautarea. "Cea mai simpla forma" presupune cuvinte fara "sufixuri" cum ar fi terminatia de plural -i, forma de gerunziu -nd, sau in engleza as -s, -ed, si -ing.)

Ponderarea

Liniarizarea

Liniarizarea este procesul prin care se ignora tagurile de mark-up dintr-un document web astfel incat continutul este reinterpretat ca un sir de caractere ce va fi notat (scored). Acest proces este transmis tag cu tag pe masura ce tagrile sunt declarate si gasite in codul sursa. Asa cum se poate vedea in figura 1, liniarizarea afecteaza modul in care motoarele de cautare "vad", "citesc" si "judeca" continutul web. Astfel, continutul unei pagini web este randat folosind doua tabele HTML incastrate (nested), fiecare avand o celula mare deasupra si formatul obisnuit cu trei coloane pe celula. Presupunem ca nici un alt text sau tag html nu mai apar in codul sursa. Numerele din dreapta sus din fiecare celula ilustreaza in ce ordine motorul de cautare gaseste si interpreteaza continutul din fiecare celula.

Inainte de liniarizare

Servicii

Companie

Carti despre caini, pisici si pasari.

Viziteaza partenerii nostrii

Dupa liniarizare

|

Magazinul de animale din Colorado Produse Servicii Companie Carti despre caini, pisici si pasari Gaseste informatii despre Hrana la vanzare Caini Pisici Pasari Cumpara acum Magazine Clienti Viziteaza partenerii nostrii |

Figura 1. Liniarizarea continutului unei pagini web construite cu tabele

Casuta de sub figura1 ilustreaza cum un motor de cautare "vede", "citeste" si "interpreteaza" continutul unui document dupa liniarizare. A se observa lipsa de coerenta si tematizare. Doua secvente de termeni ilustreaza acest aspect: "Cauta Informatia Despre Mancare la vanzare" si "Clientii Viziteaza Partenerii nostrii". Aceasta stare a continutului este probabil ascunsa ochiului neantrenat al utilizatorilor obisnuiti. In mod clar, liniarizarea are un efect negativ asupra pozitionarii cuvintelor cheie, proximitatii, distributiei si asupra continutului care trebuie "judecat" si notat. Efectul se agraveaza pe masura ce tabelele incastrate (nested) si tagurile html sunt folosite pana in punctul in care continutul liniarizat perceput de om ca misterios poate fi interpretat de un motor de cautare ca un nonsens total.

Arderea arborilor si lupta ponderilor cuvintelor cheie

In cazul cel mai favorabil, liniarizarea arata fie cuvinte, fraze sau pasaje care sfarsesc prin a concura pentru relevata intr-un arbore lexicografic distorsionat. Acest fenomen se numeste "arderea arborilor". Este una dintre cele mai neglijate probleme de optimizare.

Constructia unui arbore lexicografic din continut liniarizat ne arata starea si relatiile dintre substantive, adjective, verbe si fraze asa cum sunt ele incastrate in document. Ne arata structura de date care a fost folosita. De multe ori, liniarizarea indentifica concepte de document locale si stereotipuri gramaticale ascunse. Mandelbrot a folosit natura stereotipa a limbilor observata in arbori lexicografici pentru a propune o masura pe care el o numeste "temperatura discursului". El scrie: "Cu cat temperatura discursului este mai mare, cu atat este mai mare probabilitatea de a se fi folosit cuvinte rare." In orice caz, din punct de vedere al semanticii, raritatea cuvintelor e un context dependent de stare. Cu toate acestea, "arderea arborilor" e o consecinta naturala a plasarii incorecte a termenilor.

In Fractali si Producerea Propozitiilor, Capitolul 9 din De La Complexitate La Creativitate, Ben Goertzel foloseste un model Sistem L pentru a explica faptul ca inceputurile copilariei gramaticii este o propozitie din doua cuvinte in care stereotipul iterativ care implica substantive (N) si verbe (V) este condus de o regula in care V este inlocuit de VN (V >> VN). Acest lucru poate fi ilustrat prin urmatoarele doua etape de iterare: 0 N V (ca si in Stevie byebye)

1 N V N (ca si in Stevie byebye car)

Goertzel explica, "Motivul pentru care NV este combinatia mai naturala este pentru ca apare intr-o etapa mai timpurie a procesului de derivare." Este de inteles astfel de ce multe dintre documentele Web nu transmit mesaje atat de interesante motoarelor de cautare. Dupa liniarizare, se poate observa ca acestea pot "vorbi" ca niste copii.

"Arderea arborilor" explica de ce termenii care se repeta intr-un document nu imbunatatesc neaparat relevanta. In multe cazuri, se pot obtine chiar rezultate contrare. Este de recomandat ca utilizatorii SEO sa inceapa sa incorporeze tehnici de stereotipuri lexicografice, strategii de liniarizare si analiza de context local in optimizarile lor.

"Arderea arborilor" conduce adesea la un alt fenomen numit "lupta cuvintelor cheie". Este o problema recurenta intalnita in timpul indentificarii subiectului, segmentarii textului si analizei pe subiect. Cu toate acestea, "lupta" ingreuneaza inutil dezambiguizarea topicului si munca abstractizatorilor umani care in timpul clasificarii documentului trebuie sa raspunda la intrebari precum "Despre ce este acest document sau pasaj?", "Care este tema sau categoria acestui document, sectiune sau paragraf?", "Cum se leaga de continut acest bloc de link-uri?", etc. In timp ce liniarizarea randeaza inutil valorile KD localizate, indexarea documentelor creeaza un mit din aceasta metrica.

Tokenizarea, Filtrarea si Stemmingul.

Indexarea

documentelor este procesul de transformare a documentelor text intr-o reprezentare

de text si implica trei pasi: tokenizarea, filtrarea si

stemming-ul. In timpul tokenizarii, termenii sunt rescrisi cu litere

mici si semnele de punctuatie sunt inlaturate. Regulile trebuie

sa fie in asa fel incat cifrele, cratimele si alte simboluri pot fi

parsate corespunzator. Tokenizarea este urmata de filtrare, in timpul

filtrarii, termenii des folositi si termenii care nu adauga

semnificatie semantica sunt inlaturati. In majoritatea

sistemelor IR termenii supravietuitori sunt in continuare redusi la "tulpini"

si "radacini" comune. Acest proces este cunoscut sub numele de

stemming. Cu toate acestea, continutul initial de lungime I este

redus la o lista de termeni (tulpini si cuvinte) de lungime I' (I'< I).

Aceste procese sunt descrise in figura 2. Evident, daca liniarizarea

arata ca deja "s-au ars arborii", un motor de

cautare va indexa doar asta.

Liste similare pot fi extrase din documente individuale si unite pentru a forma un index de termeni. Acest index poate fi folosit pentru diferite scopuri; spre exemplu, pentru a calcula ponderile si pentru a reprezenta documente si interogari ca vectori de termeni in spatiul termenilor.

Ponderarea.

Ponderea unui termen intr-un document se constituie in trei tipuri diferite de ponderare a termenilor: locala, globala si normalizata. Ponderea termenului este data de

Ecuatia

2 : ![]()

unde ![]() este ponderea

locala pentru termenul i in documentul j,

este ponderea

locala pentru termenul i in documentul j, ![]() este ponderea

globala pentru termenul i si

este ponderea

globala pentru termenul i si ![]() este factorul de

normalizare pentru documentul j. Ponderile locale sunt functii care depind

de numarul de aparitii al fiecarui termen in document, ponderile

globale sunt functii care depind de numarul de aparitii in

colectie ale documentelor care contin fiecare termen, iar factorul de

normalizare corecteaza discrepantele din lungimile documentelor. In

clasicul model Termen In Spatiul Vectorilor

este factorul de

normalizare pentru documentul j. Ponderile locale sunt functii care depind

de numarul de aparitii al fiecarui termen in document, ponderile

globale sunt functii care depind de numarul de aparitii in

colectie ale documentelor care contin fiecare termen, iar factorul de

normalizare corecteaza discrepantele din lungimile documentelor. In

clasicul model Termen In Spatiul Vectorilor

Eculatiile

3, 4, si 5: ![]()

![]()

![]()

care se reduce la bine cunoscuta schema de ponderare tf*IDF.

Ecuatia 6: ![]()

unde log(D/di) inversa frecventei documentului, D este numarul de documente in colectie (marimea bazei de date) di este numarul de documente care contin termenul i. Ecuatia 6 este una din multele scheme de ponderare a termenilor care se gasesc in literatura de vectori ai termenilor. In functie de cum sunt definite L, G si N, diferite scheme de ponderare pot fi obtinute pentru documente si interogari.

Valorile KD ca estimatoare ale ponderilor termenilor?

Singura posibilitate ca valorile KD pot fi considerate valorile ponderilor termenilor

Ecuatia 7: ![]()

este ca ponderile globale sa fie ingnorate si factorul de normalizare H(j) este redefinit in termenii lungimii documentelor.

Ecuatia 8: ![]()

![]()

Cu

toate acestea, ![]() constrange ca marimea

colectiei D sa fie egala cu de 10 ori numarul documentelor care

contin termenul (d = 10*d) si

constrange ca marimea

colectiei D sa fie egala cu de 10 ori numarul documentelor care

contin termenul (d = 10*d) si ![]() implica o

filtrare fara excludere de cuvinte. Aceste conditii nu se indeplinesc in

sistemele de cautare comerciale. Folosind schema unui vector de termeni

probabilistic in care IDF este definit ca:

implica o

filtrare fara excludere de cuvinte. Aceste conditii nu se indeplinesc in

sistemele de cautare comerciale. Folosind schema unui vector de termeni

probabilistic in care IDF este definit ca:

Ecuatia 9 ![]()

de asemenea nu ajuta,

din moment ce conditia ![]() implica D - 11*d.

Constrangeri aditionale nerealistice pot fi derivate pentru alte scheme de

ponderare cand G(i) = 1.

implica D - 11*d.

Constrangeri aditionale nerealistice pot fi derivate pentru alte scheme de

ponderare cand G(i) = 1.

Pentru a concluziona, presupunerea ca valorile KD pot fi considerate ca estimarile ponderilor termenilor sau ca aceste valori pot fi folosite in scopuri de optimizare depinde de densitatea de nonsens a cuvintelor cheie

II.3. Google Page Rank si Alexa Rank.

Motorul de cautare Google a aparut in anul 1998 pe o piata pe care existau deja cateva motoare de cautare renumite, ca de ex. Altavista si Yahoo. Totusi, in decurs de cativa ani Google ajuns de la o cota de 0% la o cota de 70% din totalul cautarilor efectuate pe internet. Cauzele acestui succes rapid si covarsitor au fost in principal urmatoarele :

Extinderea numarului de pagini web indexate

Folosirea unui algoritm foarte bun care pune de cele mai multe ori paginile web cele mai relevante pentru o anumita cautare in fruntea listelor generate de Google.

Motorul de cautare Google a fost primul care a indexat paginile aflate pe domeniul Geocities, care este cel mai mare furnizor de spatiu web gratuit pe internet. Poate parea ciudat insa chiar si in anii 2000-2001 motoarele de cautare Yahoo si Altavista nu indexau aceste pagini, lucru cu atat mai surprinzator pentru Yahoo cu cat domeniul Geocities se afla de fapt in posesiunea Yahoo. Desi pe acest domeniu sunt in marea lor majoritate situri personale si nu situri profesioniste, cantitatea de informatie utila este apreciabila, iar optiunea Google de a indexa aceste pagini a facut sa creasca numarul de pagini relevante de pe listele generate de el ceea ce l-a avantajat in lupta cu competitoriii sai. Incepand cu anul 2002 dezvoltatorii celelorlalte motoare de cautare au invatat lectia si au inceput si ei sa trimita robotii sau crowlerii pentru a indexa toate domeniile care furnizeaza spatiu web gratuit, incluzand aici si domeniile care contin pagini in alte limbi decat cea engleza (de ex. Home.ro). In privinta numarului de pagini indexate Google isi mentine pozitia de lider insa competitorii sai se afla la o distanta din ce in ce mai mica.

Algoritmul folosit de Google este un prilej permanent de speculatii pentru specialistii in optimizarea paginilor web. Acestia doresc sa-i exploateze la maximum caracteristicile, pentru a impune paginile web ale celor care ii angajeaza pe primele locuri in listele generate de Google. Unele din criteriile folosite de algoritm pentru a ordona listele in functie de relevanta paginilor au fost discutate mai sus. Despre alte criterii se stie doar de existenta lor, insa nu se stie importanta pe care o au in determinarea relevantei unei pagini. Acest lucru este cauzat de faptul ca programatorii care concep algoritmul il imbunatatesc permanent, munca lor fiind similara cu munca inginerilor care imbunatatesc driverele placilor video pentru a le face sa functioneze mai eficient. Astfel, unele criterii care aveau initial o pondere mare in algoritm isi pierd cu timpul importanta pentru ca sunt descoperite criterii mai bune sau pentru ca exista tendinta ca ele sa fie exploatate in mod necinstit de catre specialistii in optimizarea paginilor web.

Unul dintre criteriile care au adus succesul motorului Google si care in prezent isi pierde treptat din importanta este stabilirea unui rang pentru fiecare pagina web. Creatorii lui Google erau studenti in momentul in care au depus un patent pentru stabilirea de ranguri pentru paginile web, patent care a stat la baza functionarii motorului Google. In mediul educational (scoli, licee, universitati) ca si in societate in general un rol important in succesul social al unui individ este determinat de popularitatea sa, adica de simpatia pe care o au ceilalti fata de el. Un individ este popular pentru ca are niste calitati care il fac sa fie apreciat de cei din jur. Din aceasta cauza el este mereu inconjurat de prieteni.

Creatorii lui Google au extrapolat aceasta observatie si au aplicat-o la lumea paginilor web. Incercand sa creeze un algoritm mai bun decat cele existente, ei au pornit de la ipoteza ca o pagina web plina de continut si utila este mult mai populara decat alte pagini care trateaza acelasi subiect dar care sunt mai sarace in continut. In mod similar cu un individ popular si pagina web populara este "inconjurata" de pagini "prietene" care au in ele legaturi catre ea. Cu alte cuvinte, cu cat o pagina a unui sit web are mai multe legaturi catre adresa ei in paginile altor situri, cu atat ea este mai populara si ca urmare putem presupune cu destula certitudine ca este o pagina utila, plina de continut informational.

Analizand numarul de legaturi care sunt indreptate catre adresa unei pagini web putem sa incadram pagina respectiva intr-un anumit rang. Motorul de cautare Google incadreaza paginile in 10 ranguri, incepand cu rangul 0 (cel mai prost) pana la rangul 10 (cel mai bun). O pagina cu rang 0 nu are nici o legatura indreptata catre ea (sau are legaturi de pe pagini cu rang 0), in timp ce o pagina cu rang 10 are o multime de pagini web care o "recomanda" prin intermediul unor legaturi. Pentru ca o pagina sa fie incadrata intr-un rang mare nu este insa suficient sa aiba un numar mare de legaturi indreptate catre ea. Algoritmul ia in calcul si "calitatea" siturilor pe care se afla legaturile. O recomandare (legatura) venita de la un sit important (de ex. Yahoo sau ODP) are mult mai multa greutate decat una venita de la un sit cvasinecunoscut.

Acest criteriu de stabilire a relevantei paginilor web nu a fost niciodata secret si ca urmare specialistii in optimizarea paginilor web l-au utilizat in mod excesiv si uneori in mod necinstit pentru a promova paginile web ale celor care ii angajasera. Programatorii de la Google au devenit constienti de acest lucru si au luat masuri adecvate pentru a-l contracara, masuri care au constat in scaderea constanta a importantei criteriului popularitatii in determinarea relevantei unei pagini.

Aceasta decizie a celor de la Google a venit pe fundalul scaderii continue a preturilor pentru echipamentele hardware performante (de ex. servere) care a permis cresterea capacitatii de procesare si de stocare a informatiilor (culese din paginile web) in baza de date. In consecinta, o data cu trecerea timpului este din ce in ce mai usor sa fie analizat mai temeinic continutul paginilor web, cel care trebuie sa fie in ultima instanta factorul decisiv in determinarea relevantei acestora. Rangul paginilor bazat pe "popularitatea" lor este folosit in continuare si este luat in consideratie atunci cand se ordoneaza lista de pagini generata de Google, insa impactul sau este mult scazut fata de anii de inceput ai lui Google.

Rangul unei pagini poate fi observat foarte usor daca instalam bara cu instrumente Google ("Toolbar") cu optiuni avansate. El este vizibil sub forma unei linii verzi care se alungeste progresiv pe masura ce pagina are un rang mai mare. Ducand cursorul mouseului peste linie putem citi rangul unei pagini vizitate.

Datorita faptului ca este cel mai folosit motor de cautare, Google starneste in permanenta discutii in randul specialistilor (dar si al nespecialistilor) cu privire la modul de ordonare a siturilor web atunci cand este cautat un anumit cuvant (sau o anumita sintagma) si este generata o lista cu siturile continand cuvintul respectiv. Algoritmul folosit de Google este secret insa cateva aspecte ale acestuia sunt explicate chiar pe situl Google in pagina PageRank Technology. De asemenea creatorii de situri web pot vizita pagina Webmaster Central tot de pe situl Google, pentru a afla cateva aspecte despre modul in care acest motor de cautare indexeaza paginile web.

Chiar daca si Google Page Rank si Alexa Rank sunt importante in SEO si masoara de fapt acelasi lucru - popularitatea unui sit - sunt totusi diferite in anumite aspecte. Aceste diferente fac importanta intelegerea conceptelor de baza privind atat Google Page Rank cat si Alexa Rank, care vor fi explicate in cele ce urmeaza.

PageRank (T) este un sistem de notare a paginilor dezvoltat de fondatorii Google Larry Page si Sergey Brin de la Universitatea Stanford.

Page Rank-ul este un sistem de notare bazat pe algoritmi dezvoltati de Google pentru a nota sau evalua paginile Web determinand relevanta acestora din perspectiva motoarelor de cautare.

Formula de calculare a Page Rank-ului ar fi:

PR(A) = (1-d) + d (PR(T1)/C(T1) + + PR(Tn)/C(Tn))

In care:

PR(Tn) - orice pagina are o notiune a propriei importante/relevante. Aceasta este "PR(T1)" pentru prima pagina continand pana la "PR(Tn)" pentru ultima pagina.

C(Tn) - Fiecare pagina imparte propriul vot catre toate link-urile ce ies din aceasta pagina. Indicele sau numarul acestor link-uri pentru prima pagina este "C(T1)" si "C(Tn)" pentru pagina "n" in continuare pentru toate paginile.

PR(Tn)/C(Tn) - In cazul in care pagina noastra A detine un link catre ea (backlink) "n", impartirea votului paginii A va primi propriul indice "PR(Tn)/C(Tn)"

d() Toate aceste parti de vot sunt adunate dar pentru a opri influenta pentru celelalte pagini, acest vot este "aruncat/ignorat" prin inmultirea cu 0.85 (factorul "d")

(1 - d) - Indicele (1 - d) de la inceput, e pentru probabilitatea matematica, astfel incat pentru "suma tuturor paginilor Page Rank-urile sa fie unul": se adauga la indicile 'pierdut' de catre d.

Deasemenea inseamna ca in cazul in care o pagina nu are link-uri catre ea (nu are backlinks) aceasta va primi un procent scazut de PR de 0.15 ( 1 - 0.85).

Pe scurt Page Rank-ul ar putea fi calculat ca fiind, 0.85 inmultit cu Page Rank-ul paginii respective si impartit la numarul de link-uri de pe pagina.

Rankul Alexa ia valori de la 1 pana 1 bilion, sau si mai mult, depinzand de numarul de situri existente. Fiecare sit aflat pe internet este inclus in Alexa Rank, deci practic concurezi cu toti. Scopul principal este sa ai un rang cat mai mare. La momentul de fata cel mai bine evaluat site pe Alexa este Yahoo.com, desi Google.com reprezinta o amenintare serioasa. Rank-ul Alexa se poate afla fie accesand direct Alexa.com fie folosind Website Popularity. Ca sa imbunatatim Rankul Alexa este nevoie sa imbunatatim traficul. Sunt destule programe pe net care pretind ca pot imbunatati Rank-ul Alexa, dar in general nu sunt eficiente si pot sa faca mai mult rau decat bine in ceea ce priveste rangul sitului. Incercarea de a inscrie situl in 300.000 de motoare de cautare e cel mai rau lucru care poate fi facut.

II.4. White Hat SEO versus Gray Hat SEO versus Black Hat SEO

Tehnicile SEO sunt clasificate de catre specialisti in doua mari categorii: tehnici pe care motoarele de cautare le recomanda ca parte a unui bun design al siturilor web si acele tehnici pe care motoarele de cautare nu le aproba, care incearca sa insele motorul de cautare sa le afiseze chiar daca nu prezinta nici un fel de relevanta pentru subiectul cautat. Persoanele care activeaza in aceasta industrie clasifica aceste metode, precum si pe cei care le practica, fie ca wihte hat SEO (cei cu palarie alba) sau black hat SEO (palarie neagra). Cei care realizeaza white hat SEO au tendinta de a produce rezultate care sa dureze o lunga perioada de timp, pe cand practicantii de black hat SEO recurg la tehnici pe care le utilizeaza o perioada scurta de timp pentru a evita ca siturile lor sa fie interzise permanent sau pentru o perioada de timp.

O tehnica SEO este considerata white hat in cazul in care acesta se conformeaza cu motoare de cautare, si cu regulile pe care acestea le impun. White hat SEO nu presupune doar respectarea regulilor impuse de motoarele de cautare, dar este acea tehnica care asigura motorul de cautare ca continutul pe care il indexeaza si ulterior il noteaza este acelasi continut pe care un utilizator uman il va vedea.

White hat SEO presupune in general, pe scurt, crearea de continut pentru utilizatori si nu pentru motoarele de cautare, prezentarea unui continut usor accesibil de catre paianjenii motoarelor de caautare, continut care nu incearca sa insele algoiritmul de cautare. Tehnica white hat este din multe puncte de vedere similara cu dezvoltarea web care promoveaza accesibilitatea, desi cele doua nu sunt identice.

Black hat SEO reprezinta acele incercari de a imbunatati ranck-ul paginii dumneavoastra prin moduri care sunt respinse de catre motoarele de cautare, sau care implica suspendarea sitului. Un dezvoltator web adept al acestui tip de optimizare foloseste text care este ascuns vizitatorului uman, fie culoarea textului este similara cu culoarea de fundal fie prin alte tehnici pe care le voi prezenta mai tarziu in cadrul acestei lucrari. Alte metode de aceeasi factura sunt cloaking-ului, continutul duplicat, fermele de link-uri notiuni care v-or fi prezentate ulterior. Motoarele de cautare pot penaliza siturile pe care le descopera folosind astfel de tehnici, fie prin reducerea ranck-ului, in cazul Google, (ceea ce presupune o pozitie mai proasta in lista de rezultate), prin refuzul de a afisa situl pentru o perioada de timp sau chiar pot elimina situl din baza lor de date. Aceste sanctiuni pot fi aplicate in mod automat de catre motoarele de cautare fie manual in cazul in care s-a pus o plangere impotriva sitului dumneavoastra.

Doua din exemplele faimoase de black hat SEO au fost BMW Germania si Ricoh Germania cand in februarie 2006 Google a decis scoaterea ambelor situri din baza de date pentru utilizarea de practici inselatoare. Ambele companii au prezentat scuze celor de la Google au remediat problemele si au fost restaurate inapoi in lista de rezultate.

Unele lucruri care au fost o data considerate strategii de wihte hat sunt astazi strategii gray hat. Gray hat SEO include lucruri cum ar fi publicarea de continut duplicat precum si usoare scheme de legaturi artificiale. Strategiile gray hat sunt in mare masura strategii white hat care sunt utilizate intr-un mod mult mai agresiv. Putem mentiona cateva exemple dintre acestea: utilizarea in atributele alt ale pozelor pe care le includeti pe sit a unor descrieri mult prea lungi care nu au nici o legatura cu descrierea pozelor ci doar include cuvintele cheie pentru care doriti sa facem optimizarea, utilizarea atributului title in mod excesiv in tagurile in care nu-si are rostul, cum ar fi <span> si <div>.

II.5. Tehnici de optimizare "White Hat SEO".

White hat SEO reprezinta acele tehnici utilizate de catre optimizatori care nu implica riscul de a fi catalogate drept SPAM de catre motoarele de cautare. SPAM-ul se defineste in literatura de specialitate ca fiind procesul de utilizare in mod abuziv a anumitor tehnici de optimizare pentru a urca cat mai sus in lista de rezultate.

Pentru a realiza o optimizare cat mai eficinta trebuie avuti in vedere o serie de factori ce vor fi prezentati in detaliu in cele ce urmeaza.

Optimizarea continutului paginii web

Motoarele de cautare sunt programate sa utilizeze in mod optim baza de date obtinuta de spiderii si crowlerii care indexeaza paginile de pe internet. Scopul lor este sa prezinte foarte rapid internautilor liste cu pagini web in care primele locuri sa fie ocupate de pagini cu un continut informativ util. Deci algoritmul de sortare a paginilor trebuie sa fie foarte bine conceput pentru ca el are rolul de a sorta mii sau zeci de mii de pagini intr-un timp foarte scurt si cu un rezultat care sa fie pe placul internautilor.

Un crowler nu vede paginile web asa cum le vad oamenii, el acorda o importanta covarsitoare textului unei pagini, fara a fi impresionat deloc de aspectul ei grafic. Ca urmare bazele de date ale motoarelor de cautare contin pagini indexate dupa continutul lor scris si nu dupa cel grafic. Acest continut scris este cel care da 70% din relevanta unei pagini web, restul de 30% fiind dat de optimizarea ('cosmetizarea') paginii web.

Sarcina lingvistilor si a matematicienilor implicati in dezvoltarea motoarelor de cautare a stat tocmai in crearea si optimizarea unui algoritm care sa poata sa ordoneze un numar mare de pagini web in functie de utilitatea continutului lor scris. In mod evident, unele din caracteristicile algoritmului nu sunt usor de sesizat de catre persoanele care nu au lucrat la el. Alte caracteristici pot fi insa deduse analizand paginile web care apar in mod constant pe primele locuri ale listelor generate de motoarele de cautare.

Este usor de intuit faptul ca algoritmul favorizeaza paginile web care au un continut de text important, pentru ca se considera ca aceste pagini contin multa informatie, iar internautii cauta in mod special aceasta caracteristica a paginilor web. Nu se stie precis cum este evaluat de catre algoritm continutul de text al unei pagini, dar este foarte posibil sa fie luat in calcul numarul de caractere (litere) din pagina asa cum a fost calculat de spiderul care a indexat pagina. Asta nu inseamna ca pentru ca paginile noastre sa aiba succes suntem obligati sa le umplem cu text pana la refuz, fara sa tinem cont si de alte aspecte, cum este de exemplu calitatea expunerii informatiilor din textul respectiv.

Paginile cu mult text sunt pe placul algoritmilor dar oamenii sunt mai rafinati, ei prefera de cele mai multe ori o cantitate rezonabila de text si care in plus trebuie sa fie interesant, util, bine scris si formatat in asa fel incat sa fie placut de citit. Un alt aspect care nu trebuie neglijat este actualizarea periodica a contintului sitului si adaugarea de noi materiale.

Atunci cand scriem textul dintr-o pagina trebuie sa ne asiguram ca folosim si sinonime pentru cuvintele-cheie si de asemenea ca folosim si variante mai putin folosite ale acestora. De exemplu intr-o pagina web care trateaza un subiect despre siturile web (gazduire de ex.) trebuie folosit in principal cuvantul 'sit' dar trebuie pusa in paranteza si varianta 'site', inca destul de folosita desi este incorecta. In acest fel daca un internaut va cauta paginile care contin sintagma "gazduire site web" avem toate sansele ca si pagina noastra care trateaza acest subiect sa fie luata in seama de motorul de cautare pentru includere pe lista rezulatelor cautarii.

Clasa de domenii.

Clasa de domenii reprezinta un factor oarecum important pentru motoarele de cautare. Spre exemplu: .edu si .org sunt domenii privilegiate in ochii motoarelor de cautare; .com deasemenea, cu specificatia ca sunt verificate des datorita SPAM-ului creat pe unele situri ce detin astfel de domenii; .info a devenit destul de bine vazut de catre motoarele de cautare; .ro e regional si deci ele au importanta, in general, pentru sectiunile locale/regionale ale unor motoare de cautare ce ofera si aceasta optiune de cautare

Marimea fisierelor.

Dimensiunea paginilor trebuie sa fie cat mai redusa deoarece atunci cand un utilizator acceseaza pagina aceasta sa se incarce cat mai repede. Prin aceasta optimizare de dimensiune se diminueaza riscul ca vizitatorii sa paraseasca pagina inainte de a fi incarcata in browser.

Pentru o viteza de incarcare cat mai buna a paginii trebuie ca CSS-urile si javascriptul sa fie tinute pe cat posibil in fisiere separate, iar imaginilor din situl dumneavoastra trebuie sa le specificati dimensiunile ca in exemplu urmator:

<img src="imaginea-mea.gif" alt="descriere" height="300" width="200">

Actualizarea continutului

E indicat ca la o anumita perioada sa actualizati continutul de pe pagini. Google si celelalte motoare de cautare pretuiesc paginile cu continut actualizat. Actualizarea continutului isi poate aduce o indexare frecventa si deci rezultate profitabile.

Varsta site-ului Web

Motoarele de cautare specifica faptul ca siturile vechi sunt de incredere, sunt stabile. Siturile Web cu o varsta marita de existenta, detin locuri privilegiate in ochii Googlelui si a celorlalte si deci a rezultatelor dupa cautari. Chiar daca aveti un sit nou este bine ca sa va achizitionati domeniul pe o perioada cat mai lunga de timp astfel crescand credibilitatea in "ochii" motoarelor de cautare.

Alegerea numelui domeniului.

Este foarte important sa alegeti un nume potrivit pentru situl dumneavoastra. Pentru o buna indexare este indicat ca numele domeniului sa contina cuvintele cheie, dar nu mai mult de doua maxim trei. Deoarece numele de domenii trebuie sa fie usor de retinut trebuie evitata alegerea unor nume lungi cum ar fi spre exemplu: magazin-online-electornice-electrocasnice-calculatoare chiar daca aceste nume lungi pot ingloba mult mai multe cuvinte cheie.

Trebuie mentionat urmatorul fapt: cratima (-) este interpretata de motoarele de cautare ca fiind spatiu si astfel un nume de domeniu de genul televizoare-color va fi mult mai bun decat televizoarecolor din punct de vedere al indexarii insa il va face mai greu de retinut.

Meta Tagurile.

Atunci cand oamenii se refera la meta taguri ei vorbesc despre meta tagurile descrption si keywords. Cateva din motoarele de cautare pot afisa continutul tagului description ca parte a rezultatelor de cautare, dar continutul tagului keywords nu ar trebui sa apara in rezultatele de cautare.

Meta tagurile arata astfel:

<meta name='keywords' content='carti SEO, SEO tutoriale, search engine optimisation, search engine optimisation tutorial, trucuri de optimizare web' />

<meta name='Description' CONTENT='tutoriale-seo.ro va pune la dispozitie o serie de materiale care va vor ajuta sa imbunatatiti pozitia sitului dumneavoastra in lista de rezultate a motoarelor de cautare. Aici veti gasi o serie de trucuri de optimizare precum si ultimile tendite in domeniu' />

Jon Glick inginer la Yahoo a declarat ca meta tag-ul keywords este folosit pentru a include o pagina printre un subset de rezultate de cautare, dar nu este folosit in stabilirea relevantei acelei pagini pentru un termen de cautare dat.

Daca utilizati tag-ul meta keywords acesta ar trebui sa fie unic pentru fiecare pagina pe care-l puneti. Tag-ul keywords este cel mai potrivit loc pentru a pune cuvinte scrise cu cele mai comune greseli de ortografie (spre exemplu erore in loc de eroare), sinonime si alte versiuni ale unui cuvant.

Nivelul de relevanta al meta tag-ului description difera de la un motoar de cautare la altul. Multe motoare de cautare sprijina in continuare utilizarea acestui tag si-l afisaza in pagina de rezultate. Este indicat ca atunci cand utilizati acest tag in frazele din descriere sa introduceti principalele cuvinte cheie dar intr-o maniera care sa nu afecteze cursivitatea exprimarii sau logica propozitiei.

Exemplu:

Dupa cum se poate observa in exemplul anterior o parte din descriere este afisata in rezulatul returnat de Google.

Link-urile catre situl ce se doreste a fi optimizat.

Link-urile catre situl tau influenteaza intr-o masura destul de mare pozitia in lista de rezultate imbunatatind page-rank-ul sitului. Deaceea voi aocorda o atentie sporita acestei etape a procesului de optimizare.

Majoritatea proprietarilor de situri prefera sa adune linkuri folosind un schimb de linkuri cu alti webmasteri. Este o practica destul de veche, si nu mai este atat de eficienta precum a fost o data, si asta pentru ca foarte multi webmasteri de situri abuzeaza de aceasta practica. Google a inceput sa penalizeze cumpararea de linkuri si din acest motiv este de recomandat atentie la acest capitol.

Ei vor linkuri catre siteul lor venind practic de la orice site. Asta este o practica proasta pentru ca spiderii motoarele de cautare au fost programati sa ignore linkurile aflate pe un sit si care nu sunt relevante pentru continutul acestuia. De exemplu, daca un sit despre pianuri trimite un link catre un sit despre caini, linkul sitului despre caini va fi ocolit de catre spider sau greutatea lui va fi diminuata. De aceea este foarte important sa obtineti linkuri relevante si de calitate daca va decideti sa faceti schimb de linkuri.

Obtinerea unor linkuri de calitate poate sa fie o provocare destul de dificila, de aceea cel mai bine este sa folositi inscrierea in directoare. Inscrierea in directoare iti ofera posibilitatea sa obtii repede si usor linkuri relevante catre situl tau. Aceste linkuri sunt urmarite de catre spiderii motoarelor de cautare si nu sunt aproape niciodata ignorate. Tot ceea ce aveti de facut este sa va inscrieti situl in directoare la o categoria relevanta, impreuna cu o descriere si un titlu relevant.

Website Submitter este cel mai usor de folosit soft semi-automatizat pentru inscrierea in directoare. Puteti sa va promovati situl rapid si sigur pentru a obtine rezultate reflectate in numarul de vizitatori primiti. Va puteti inscrie situl la peste 3500 de directoare straine si 400 de directoare romanesti. Website Submitter face toata treaba pentru dumneavoastra. Ceea ce este cel mai important este ca Website Submitter are inclusa si o lista cu 400 de directoare romanesti.

Avantajele inscrierii in directoare:

Situl este listat impreuna cu alte situri relevante. Dupa cum am mai spus spiderii au fost programati sa ignore linkurile catre siturile nerelevante sau sa le scada importanta. Directoarele clasifica siturile in anumite categorii, asa ca daca spiderul motoarelor de cautare gaseste linkul sitului dumneavoastra intr-un director si in categoria corespunzatoare, atunci spiderul va va vizita situl prin acel link.

Este rapid Poate sa fie frustrant si chiar enervant sa cautati situri relevante pentru situl dumneavostra si sa le cereti sa trimita link catre situl dumneavostra. Veti fi de asemenea nevoiti sa le trimiteti inapoi link de pe situl dumneavoastra. Este nevoie de o groaza de timp sa trimiteti emailuri catre webmasteri de situri si sa ii rugati sa puna un link catre situl pe care vreti sa-l promovati. Este un timp pe care majoritatea creatorilor de situri nu il au la dispozitie si lipsa acestuia se poate reflecta in neglijarea calitatii sitului. Inscrierea intr-un director dureaza in general mai putin de 1 minut folosind Website Submitter.

Este eficient. Multe dintre cele mai bine optimizate situri pentru motoarele de cautare au majoritatea linkurilor catre situl lor provenind din directoare. Inscrierea in directoare poate sa aduca, si de obicei o face, un aflux de vizitatori si o mai buna pozitionare in mototarele de cautare.

O alta metoda de a obtine linkuri catre situl dumneavoastra care este, cel putin la momentul de fata, mai putin folosita o reprezinta publicarea de articole pentru a obtine linkuri catre situl pe care vrem sa-l optimizam. Este extrem de eficienta si poate sa imbunatateasca pozitionarea in motoarele de cautare extrem de rapid. Publicare de articole inseamna scrierea unui articol si inscrierea lui intr-un director de articole. Aceste directoare fie publica articolul fie il trimit mai departe catre diferite situri care il afiseaza pe internetnet. Oamenii, ca si spiderii motoarelor de cautare, pot citi apoi articolul si accesa linkurile continute in el.

Article Submitter va poate publica articolul in peste 600 de directoare de articole rapid si eficient. Obtineti astfel o plasare precisa a articolelor in cele mai populare directoare folosind un instrument de inscriere semiautomatizat care va va oferi posibilitatea sa va concentrati asupra scrierii continutului propriu zis, si nu asupra publicarii lui.

Atunci cand publicati un articol este important ca acesta sa aiba legatura cu situl pe care il promovati, prin urmare daca aveti un sit despre materiale de constructii articolul ar putea sa prezinte una din inovatiile in domeniu, o metoda de utilizare a anumitor materiale sau orice subiect care sa aiba legatura cu situl dumneavoastra.

Densitatea cuvintelor cheie.

Este in general acceptat de catre specialisti faptul ca o pagina in care cuvintele cheie apar de mai multe ori in text va fi mai bine plasata in lista decat o pagina in care cuvintele cheie nu apar deca o singura data. Daca un internaut cauta paginile relevante care contin cuvintele 'reparare biciclete', acele pagini care contin de mai multe ori aceasta sintagma vor fi mai bine plasate decat acelea care nu o contin decat o data sau de doua ori.

In mod normal atunci cand scriem un text, cuvintele cheie (cele mai importante) vor aparea de mai multe ori in mod natural, pentru ca explicatiile noastre au nevoie de ele. Lingvistii angajati de companiile proprietare ale motoarelor de cautare interpreteaza aceasta aparitie repetata a cuvintelor-cheie ca un semn ca pagina respectiva este relevanta pentru informatii referitoare la cuvintele-cheie in cauza. In consecinta ei au recomandat programatorilor algoritmilor motoarelor de cautare sa faca in asa fel incat paginile care au o densitate 'naturala' a cuvintelor-cheie sa fie plasate in fruntea listei.

Densitatea naturala implica repetarea dupa portiuni variabile de text, spre deosebire de densitatea 'artificiala' care implica repetarea cuvintelor-cheie in mod excesiv unele dupa altele si care era folosita in mod fraudulos de catre unii webmasteri. De exemplu sintagma 'reparare biciclete' poate aparea in mod natural intr-o fraza in care se spune : 'Firma noastra propune servicii de reparare a bicicletelor la preturi rezonabile' si apoi poate aparea din nou la o distanta de unul sau mai multe paragrafe intr-o alta fraza, in care se spune : 'Repararea unei biciclete necesita folosirea atat a unor unelte comune oricarei reparari a unui vehicul cat si a unor unelte speciale pentru biciclete'.

Aceasta densitate 'naturala' este un subiect de dezbatere pentru specialistii in optimizarea paginilor web pentru ca ei nu au de unde sa stie ce este considerat 'natural' si ce este considerat 'artificial' de catre lingvistii a caror expertiza a stat la baza crearii algoritmilor. In general se considera ca aparitia intr-o pagina de 5-10 ori a cuvintelor cheie la intervale variabile de text este considerata naturala.

Tagurile html si rolul acestor in procesul de optimizare.(optimizare onpage).

Utilizarea corecta a tagurilor html va pot aduce cateva avantaje in ceea ce priveste optimizarea pentru motoarele de cautare. Incercati sa va pozitionati corect cuvintele cheie in interiorul paginii.

tagul <title> </title> este utilizat pentru a face o descriere succinta a paginii pe care o avem incarcata in browser. Este recomandat ca in interiorul acestui tag sa inseram doua, trei cuvinte cheie. Spre exemplu daca avem un sit de prezentare a unei companii ce ofera software de gestiune tag-ul title ar putea arata cam asa:

<title>Nume Comanie va pune la dispozitie un pachet de software de gestiune care acopera o gama larga de domenii de activitate </title>

utilizati cuvintele cheie in paragrafe <p></p>

utilizati cuvintele cheie in tagurile <hi></hi> i = 1..6;

Tagurile <b></b>, <strong> </strong> si <i> </i>. Este bine ca o parte din cuvintele cheie reprezentative pentru situl dumneavoastra sa fie incadrate intre taguri <b>, <i> sau <strong> deoarece motoarele de cautare acorda o importanta mai mare sintagmeleor dintre aceste taguri. Este bine sa recurgeti la aceasta strategie atunci cand aceste cuvinte au o anumita insemnatate aparte in context sau au rolul de a intari ideea pe care doriti sa o exprimati

incercati sa includeti cateva cuvinte si in liste (bulleted lists)

atunci cand este posibil este indicat sa le utilizati si in link-urile interne ale sitului dumneavoastra.

in cazul in care pagina dumneavoastra web are un continut bogat in fotografii exploatati la maximum atributul alt. Acest atribut este utilizat pentru a oferi vizitatorilor o descriere relevanta a ceea ce reprezinta poza atunci cand pozitionati mouse-ul pe poza respectiva sau cand aceasta nu poate fi incarcata in browser din varii motive. Este indicat ca acestea sa nu contina mai mult de cinci - sase cuvinte si ca o parte din cuvinte sa fie cuvinte cheie.

utilizati atributul title pentru link-uri. Acesta are acelasi comportament ca si atributul alt in cazul pozelor.

In principiu este bine sa raspandim cuvintele cheie in toaa pagina pentru a fi mai bine indexati de motarele de cautare.

Constructia fisierului/fisierelor CSS

Constructia fisierului css este un aspect

cu o relevanta nu foarte mare in indexarea paginilor web insa nu

trebuie ignorat. Este recomandat ca numele claselor css sau id-urile sa

fie cuvinte cheie deoarece acestea au o oarecare importanta in

calculul page rank-ului.

Cel mai bun exemplu in acest sens este situl: www.soccer.com, care este primul

rezultat returnat de google.com atunci cand se introduce cuvantul soccer in

caseta de cautare, in a carui prima pagina cuvantul soccer se regaseste la

o prima vedere doar de 3 ori insa la un studiu amanuntit al codului

paginii veti regasi cuvantul de mai mult de 700 de ori.

Indexare in principalul motor de cautare in mai putin de 24 de ore.

O multime de oameni sugereaza sa va inscrieti situl in Google folosind formularul de adaugare link. Din pacate, asta nu da niciodata rezultate bune. Motivul ar fi ca inscrierea nu este verificata timp de saptamani intregi datorita faptului ca Google este prea ocupat. Deci ati putea la fel de bine sa uitati despre inscriere linkului in formularul Google pentru ca nu are sa va ajute de loc.

Sunt de fapt cateva lucruri pe care ati putea sa le incercati, fiecare fiind destul de eficient, si care va pot ajuta sa aveti situl indexat in mai putin de 24 ore. Incearcati-le pe toate si o sa observati ce efecte pozitive vor avea.

Un link pe un alt sit existent

Linkurile catre situl dumneavostra sunt extrem de importante pentru a fi listati in Google. Ele maresc probabilitatea ca un paianjen/spider sa va viziteze situl, acest lucru ducand la listarea si pozitionarea sitului in motoarele de cautare. Daca sunteti abia la inceput, poate sa fie extrem de dificil sa obtineti asemenea linkuri pentru ca situl dumneavoastra este inca necunoscut. De aceea, trebuie sa incercati alte modalitati pentru a face asta. Una din cele mai usoare cai este sa va inscrieti intr-un forum al unui sit cuoscut si sa incepeti sa postati. Nu trebuie sa faceti o multime de posturi, doar cateva posturi de calitate vor fi de ajuns. Puneti un link catre situl dumneavoastra in semnatura. Spiderii motoarelor de cautare il vor observa imediat.

O alta cale usoara de a face asta este sa va duceti la un blog cunoscut si sa postati un comentariu. Aici trebuie sa aveti grija ca sa nu va faceti comentariu sa para ca e spam. Scrieti un comentariu inteligent si semnati-va ceva in genul: www.situlmeu.com. Astfel proprietarii blogurilor vor sti ca nu sunteti doar un bot ci o persoana normala careia ii pasa de subiectul blogului.

Creeati un blog extern

Blogurile sunt extrem de apreciate de Google. Atat de mult, incat de fapt sunt foarte repede indexate. Un post intr-un blog poate sa fie indexat de google in mai putin de 24 de ore. Va puteti duce la oricare sit gratuit ca blogspot.com si sa va creeati un blog acolo. Puteti apoi scrie cateva posturi si cateodata sa lasati un link catre situl dumneavoastra in ele. Cu putin noroc, situl dumneavoastra va fi indexat de motorul de cautare google destul de repede.

Adaugati un blog sitului dumneavoastra.

Adaugarea unui blog sitului dumneavoastra poate sa fie mult mai eficient decat creearea unui blog extern sau chiar postarea de mesaje in forumuri. Exista softuri gratuite precum Wordpress, Joomla etc care ofera posibilitatea sa adaugati un blog sitului dumneavoastra repede si usor. Puteti adauga apoi cateva posturi de calitate (neparat cu incluziune de anumite cuvinte cheie ). Deoarece Google iubeste blogurile si le indexeaza extrem de repede, va puteti astepta ca blogul dumneavoastra sa fie bagat in seama si implicit si situl foarte repede. Aceasta este cea mai eficienta metoda de a fi indexati repede, deci nu o ignorati.

De ce functioneaza aceste metode?

In primul si al doilea caz, obtineti mai multe linkuri catre situl dumneavoastra. Asta inseamna ca atunci cand Google va viziteaza siturile si observa un link catre situl dumneavoatra pe ele, se vor duce si la sit si il vor indexa. Linkurile practic imbunatatesc intotdeauna pozitionarea in motoarele de cautare pentru ca sunt mai multe sanse pentru spideri/paianjeni sa va viziteze situl . Asa ca nu ignorati aceste linkuri si rolul lor in indexarea mai rapida a sitului dumneavoastra. Cu a treia metoda beneficiati de faptul ca Google indexeaza blogurile mai repede decat siturile normale. Prin adaugarea unui blog sitului dumneavoastra, va deschideti situl pentru a fi indexat de google mai repede decat o fac ei in mod normal. Asta este probabil cea mai importanta metoda, asa ca asigurati-va ca o sa o folositi corect.

II.6. Tehnici de optimizare "Black Hat SEO".

Sunt multe opinii pe internet despre practicile neortodoxe folosite de unii pentru a creste performantele siturilor la cautarile pe Google si celelalte motoare de cautare . De la bun inceput trebuie precizat ca aceste practici sunt interzise de catre toate motoarele de cautare si pot duce la excluderea din baza lor de date. Insa asemenea practici sunt descoperite frecvent la mari sit-uri care fac legea in domeniul lor fara nici un fel de repercursiuni.

Iata cateva practici de optimizare considerate ca fiind inselatoare si interzise de catre Google si celelalte motoare de cautare:

Cloaking. In foarte multe cazuri creatorii de situri web in loc sa isi canalizeze toate eforturile pe creearea de pagini cu continut relevant pentru motoarele de cautare care sa aduca vizitatori sitului lor doar datorita continutului de calitate pe care il ofera, acestia sunt tentati sa-si proiecteze paginile exclusiv pentru motoarele de cautare. Acest lucru se manifesta prin realizarea unor pagini cu prea multe cuvinte cheie sau alti factori care ar putea fi considerati ca fiind prietenosi cu motarele de cautare dar care fac ca paginile sa fie dificil de "digerat" de vizitatorii umani. Ca atare, practicantii de Black Hat SEO considera cloaking-ul a fi o tehnica importanta pentru targhetarea doar a paianjenilor motoarelor de cautare. Cloaking-ul se manifesta prin aceea ca paginile prezinta continut diferit motoarelor de cautare fata de vizitatorii umani.

Aceasta se realizeaza prin furnizarea de continut in functie de adresa IP sau de HTTP User-Agent header-ul utilizatorului care solicita pagina. Atunci cand un utilizator este identificat ca fiind un spider al unui motor de cautare, un script pe partea de server ii ofera o alta versiune a paginii web al carei continut nu este prezent in pagina vizibila, cea returnata vizitatorului uman. Scopul cloaking-ului este de a induce in eroare motoarele de cautare, astfel incat acestea sa afiseze pagina in lista de rezultate cand in mod normal aceasta nu ar fi afisata.

Text/Legaturi ascunse. Textul si legaturile optimizate pentru motoarele de cautare dar total irelevante pentru vizitatori sunt ascunse folosind culoarea identica cu cea a fundalului. De cele mai multe ori aceste texte contin o lista lunga de cuvinte cheie irelevante pentru vizitatori. Exista de asemenea o gramada de alte metode de a ascunde textul de catre vizitator dintre care va voi prezenta cateva:

utilizarea div-urilor ascunse. Acestea se pot realiza utilizand atributul CSS visibility:hidden prin urmare tot continutul acestui div va fi vazut doar de spiderii motoarelor de cautare;

utilizarea unor blocuri de tex pozitionate in spatele unor imagini cu ajutorul proprietatii z-index. Aceasta trebuie sa aiba o valoare mai mica decat cea a fotografiei dupa care este ascuns textul dorit.

inserarea in sit a unor imagini de un pixel pe un pixel de culoarea backgroundului in al caror atribut alt sa introducem cuvinte cheie dupa care dorim sa fie indexat situl.

Doorway pages. Aceste pagini sunt create special pentru motoarele de cautare, contin foarte multe legaturi si nu au continut util pentru vizitatori fiind concepute pentru a manipula modul cum se realizeaza indexarea. La incarcarea in browser in general vizitatorii sunt redirectati automat catre alta pagina prin javascript, prin scripturi pe parte de server sau cu ajutorul tagului meta refresh ca in exemplul urmator:

<meta http-equiv 'refresh' content '0;url=https://domeniu.com' >Capitolul III Realizare SEO pentru situl www.stascomputer.ro

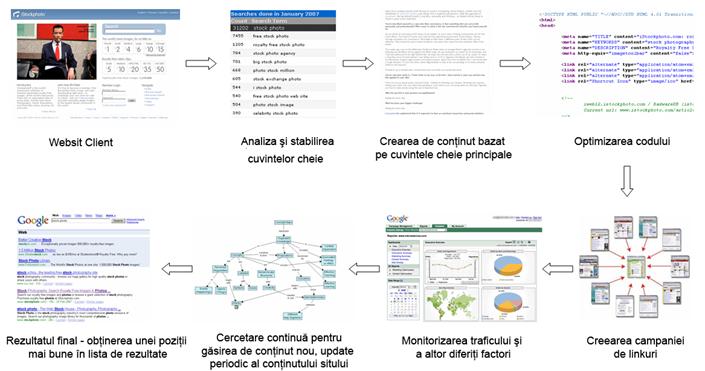

1. Pasii parcursi pentru relizarea optimizarii

In mod normal realizarea optimizarii ar trebui executata de la bun inceput inainte de lansarea sitului facand astfel procesul de optimizare mult mai usor de infaptuit, insa in multe cazuri aceasta trebuie facutapornind de la un sit deja existent asa cum este si cazul prezentat in cele ce urmeaza.